- Tổng quan

- Nội dung

- Tiêu chuẩn liên quan

- Lược đồ

- Tải về

Tiêu chuẩn TCVN 14364:2025 Công nghệ thông tin - Trí tuệ nhân tạo - Khung cho hệ thống trí tuệ nhân tạo sử dụng học máy

| Số hiệu: | TCVN 14364:2025 | Loại văn bản: | Tiêu chuẩn Việt Nam |

| Cơ quan ban hành: | Bộ Khoa học và Công nghệ | Lĩnh vực: | Khoa học-Công nghệ , Sở hữu trí tuệ |

| Trích yếu: | ISO/IEC 23053:2022 Công nghệ thông tin - Trí tuệ nhân tạo - Khung cho hệ thống trí tuệ nhân tạo sử dụng học máy | ||

|

Ngày ban hành:

Ngày ban hành là ngày, tháng, năm văn bản được thông qua hoặc ký ban hành.

|

02/06/2025 |

Hiệu lực:

|

Đã biết

|

| Người ký: | Đang cập nhật |

Tình trạng hiệu lực:

Cho biết trạng thái hiệu lực của văn bản đang tra cứu: Chưa áp dụng, Còn hiệu lực, Hết hiệu lực, Hết hiệu lực 1 phần; Đã sửa đổi, Đính chính hay Không còn phù hợp,...

|

Đã biết

|

TÓM TẮT TIÊU CHUẨN VIỆT NAM TCVN 14364:2025

Khung cho hệ thống trí tuệ nhân tạo sử dụng học máy tại Việt Nam

Ngày 02/06/2025, Bộ Khoa học và Công nghệ đã công bố Tiêu chuẩn quốc gia TCVN 14364:2025 ISO/IEC 23053:2022 về Công nghệ thông tin - Trí tuệ nhân tạo - Khung cho hệ thống trí tuệ nhân tạo sử dụng học máy. Tiêu chuẩn này sẽ có hiệu lực cùng ngày.

Tiêu chuẩn này thiết lập khung cho các hệ thống trí tuệ nhân tạo (AI) sử dụng học máy (ML), áp dụng cho tất cả các tổ chức, bao gồm cả doanh nghiệp nhà nước và tư nhân, cũng như các tổ chức phi lợi nhuận, nhằm mô tả và quản lý các hệ thống AI.

Mục đích và nội dung của tiêu chuẩn

Tiêu chuẩn cung cấp một khuôn khổ để mô tả các hệ thống AI sử dụng ML, với các thuật ngữ và khái niệm chuẩn nhằm giải thích và giảm thiểu các mối quan tâm liên quan đến thiết kế và ứng dụng của các hệ thống này. Nó áp dụng cho cả chuyên gia và những người không chuyên trong lĩnh vực công nghệ.

Các thuật ngữ chính trong tiêu chuẩn

- Học máy (ML): Là một nhánh của trí tuệ nhân tạo cho phép các hệ thống học tập từ dữ liệu và cải thiện hiệu suất qua việc tối ưu hóa thuật toán.

- Mô hình phân loại: Là mô hình ML có đầu ra dự kiến từ đầu vào là một trong nhiều loại.

- Mô hình hồi quy: Là mô hình với đầu ra là biến liên tục dựa trên đầu vào đã cho.

- Phân cụm, phát hiện bất thường và giảm chiều dữ liệu cũng là các khía cạnh quan trọng trong tiêu chuẩn.

Phạm vi áp dụng và tài liệu viện dẫn

Tiêu chuẩn này cung cấp một khuôn khổ tổng quát cho việc triển khai các hệ thống AI, cụ thể cho việc phát triển, sử dụng và duy trì các mô hình ML. Các tài liệu viện dẫn như TCVN 13902:2023 được nêu rõ là cần thiết cho việc thực hiện tiêu chuẩn.

Hệ thống và quy trình học máy

Khung do tiêu chuẩn đề xuất mô tả cách các phần tử trong hệ thống ML hoạt động, bao gồm các mô hình, công cụ, và chức năng của chúng trong việc phát triển ứng dụng AI. Nó nhấn mạnh sự cần thiết phải tách biệt các loại dữ liệu khác nhau trong quá trình huấn luyện và thử nghiệm mô hình ML để đảm bảo tính chính xác và hiệu quả.

Tiêu chuẩn TCVN 14364:2025 là cơ sở để phát triển các tiêu chuẩn chi tiết khác về AI và ML, nhằm đảm bảo rằng những công nghệ này được thiết kế và triển khai một cách hiệu quả, an toàn và minh bạch, phù hợp với nhu cầu và điều kiện thực tiễn tại Việt Nam.

Tải tiêu chuẩn Việt Nam TCVN 14364:2025

TIÊU CHUẨN QUỐC GIA

TCVN 14364:2025

ISO/IEC 23053:2022

CÔNG NGHỆ THÔNG TIN - TRÍ TUỆ NHÂN TẠO - KHUNG CHO HỆ THỐNG TRÍ TUỆ NHÂN TẠO SỬ DỤNG HỌC MÁY

Information technology - Artificial intelligence - Framework for Artificial Intelligence (AI) Systems Using Machine Learning (ML)

Lời nói đầu

TCVN 14364:2025 hoàn toàn tương đương với ISO/IEC 23053:2022.

TCVN 14364:2025 do Viện Công nghiệp số và Chuyển đổi số quốc gia biên soạn và đề nghị, Ủy ban Tiêu chuẩn Đo lường Chất lượng Quốc gia thẩm định, Bộ Khoa học và Công nghệ công bố.

Lời giới thiệu

Các hệ thống trí tuệ nhân tạo (AI) nói chung, là các hệ thống được thiết kế để tạo các đầu ra như nội dung, dự báo, khuyến nghị hoặc quyết định cho một tập hợp các mục tiêu do con người xác định. AI bao gồm nhiều công nghệ phản ánh các cách tiếp cận khác nhau để giải quyết các vấn đề phức tạp này.

Học máy (ML) là một nhánh của AI sử dụng các kỹ thuật tính toán cho phép các hệ thống học hỏi từ dữ liệu hoặc kinh nghiệm. Nói cách khác, các hệ thống ML được phát triển thông qua việc tối ưu hóa các thuật toán để phù hợp với dữ liệu huấn luyện hoặc cải thiện hiệu năng của chúng dựa trên việc tối đa hóa phần thưởng. Các phương pháp ML, bao gồm cả học sâu cũng được đề cập trong tiêu chuẩn này.

Các thuật ngữ như tri thức, học và quyết định được sử dụng xuyên suốt trong toàn bộ tiêu chuẩn. Tuy nhiên, điều đó không chủ ý đề cập đến việc nhân cách hóa học máy.

Mục đích của tiêu chuẩn này nhằm cung cấp một khuôn khổ để mô tả các hệ thống AI sử dụng ML. Bằng việc đưa ra các thuật ngữ và khái niệm chung cho các hệ thống này, tiêu chuẩn cung cấp sở cứ để giải thích rõ về các hệ thống và những mối quan tâm khác nhau trong thiết kế và sử dụng chúng. Tiêu chuẩn này áp dụng cho các đối tượng là chuyên gia và người không phải là chuyên gia. Tuy nhiên, một số điều khoản (được xác định trong phần tổng quan tại Điều 5) bao gồm các mô tả kỹ thuật chuyên sâu hơn.

Tiêu chuẩn này cũng cung cấp sở cứ cho các tiêu chuẩn khác đề cập đến các khía cạnh cụ thể về hệ thống ML và các thành phần của chúng.

CÔNG NGHỆ THÔNG TIN - TRÍ TUỆ NHÂN TẠO - KHUNG CHO HỆ THỐNG TRÍ TUỆ NHÂN TẠO SỬ DỤNG HỌC MÁY

Information technology - Artificial intelligence - Framework for Artificial Intelligence (AI) Systems Using Machine Learning (ML)

1 Phạm vi áp dụng

Tiêu chuẩn này thiết lập khung Trí tuệ nhân tạo (AI) và Học máy (ML) để mô tả tổng quát hệ thống AI sử dụng công nghệ ML. Khung mô tả các thành phần hệ thống và chức năng của nó trong hệ sinh thái AI. Tiêu chuẩn này áp dụng cho tất cả các loại hình và quy mô của tổ chức, bao gồm cả các công ty nhà nước và tư nhân, các tổ chức chính phủ và các tổ chức phi lợi nhuận đang triển khai hoặc sử dụng các hệ thống AI.

2 Tài liệu viện dẫn

Các tài liệu viện dẫn sau đây rất cần thiết cho việc áp dụng tiêu chuẩn này. Đối với các tài liệu viện dẫn ghi năm công bố thì áp dụng phiên bản được nêu. Đối với các tài liệu viện dẫn không ghi năm công bố thì áp dụng phiên bản mới nhất, bao gồm cả các sửa đổi (nếu có)..

- TCVN 13902:2023 (ISO/IEC 22989) Công nghệ thông tin - Trí tuệ nhân tạo - Các khái niệm và thuật ngữ.

3 Thuật ngữ và định nghĩa

Trong tiêu chuẩn này sử dụng các thuật ngữ, định nghĩa trong TCVN 13902:2023 (ISO/IEC 22989) và các thuật ngữ, định nghĩa sau.

3.1 Phát triển và sử dụng mô hình

3.1.1

Mô hình phân loại (classification model)

<học máy> mô hình học máy có đầu ra dự kiến từ một đầu vào đã cho là một hoặc nhiều loại.

3.1.2

Mô hình hồi quy (regression model)

<học máy> Mô hình học máy có đầu ra dự kiến từ một đầu vào đã cho là một biến liên tục.

3.1.3

Khái quát hóa (generalization)

<học máy> khả năng của một mô hình được huấn luyện để đưa ra các dự đoán chính xác dữ liệu đầu trước đó chưa biết.

CHÚ THÍCH 1: Mô hình học máy khái quát hóa tốt là mô hình có độ chính xác của dự đoán chấp nhận được bằng cách sử dụng dữ liệu đầu vào trước đó chưa biết.

CHÚ THÍCH 2: Khái quát hóa có liên quan chặt chẽ đến sự quá phù hợp. Một mô hình học máy quá phù hợp sẽ không khái quát hóa tốt vì mô hình phù hợp một cách quá chính xác với dữ liệu đào tạo.

3.1.4

Quá phù hợp (overfitting)

<học máy> tạo ra một mô hình phù hợp với dữ liệu huấn luyện một cách quá chính xác và không thể khái quát hóa đối với dữ liệu mới.

CHÚ THÍCH 1: Quá phù hợp có thể xảy ra do mô hình được huấn luyện học được những thuộc tính không thực chất trong dữ liệu huấn luyện (tức là các đặc tính không khái quát hóa thành đầu ra hữu ích), quá nhiễu trong dữ liệu tập huấn (ví dụ: số lượng ngoại lệ quá nhiều) hoặc do mô hình quá phức tạp đối với dữ liệu huấn luyện.

CHÚ THÍCH 2: Quá phù hợp có thể được xác định khi có sự khác biệt đáng kể giữa các sai số được đánh giá trên dữ liệu huấn luyện, dữ liệu kiểm tra và dữ liệu thẩm định riêng rẽ. Hiệu năng của mô hình quá phù hợp đặc biệt bị ảnh hưởng không có sự phù hợp đáng kể giữa dữ liệu huấn luyện và dữ liệu sản xuất.

3.1.5

Không phù hợp (underfitting)

<học máy> tạo ra một mô hình không đủ khớp với dữ liệu đào tạo và tạo ra các dự đoán không chính xác về dữ liệu mới.

CHÚ THÍCH 1: Không phù hợp có thể xảy ra khi các đặc tính được lựa chọn một cách nghèo nàn, thời gian đào tạo không đủ hoặc khi mô hình quá đơn giản để học từ dữ liệu huấn luyện lớn do năng lực hạn chế của mô hình (tức là năng lực biểu đạt).

3.2 Công cụ

3.2.1

Lan truyền ngược (backpropagation)

Phương pháp huấn luyện mạng nơ-ron sử dụng sai lệch ở đầu ra để điều chỉnh và tối ưu hóa các trọng số cho các liên kết từ các lớp kế tiếp nhau trước đó.

3.2.2

Tốc độ học (learning rate)

Kích thước bước trong một phương pháp độ dốc (gradient).

CHÚ THÍCH 1: Tốc độ học xác định xem liệu một mô hình có nhanh hội tụ đến một giải pháp tối ưu hay không, nó thành một siêu tham số quan trọng để thiết lập cho các mạng nơ-ron.

3.3 Dữ liệu

3.3.1

Loại (class)

Loại hình của các phần tử do con người định nghĩa là một phần của bộ dữ liệu có các đặc tính chung.

VÍ DỤ: "điện thoại", "bàn", "ghế", "vòng bi" và "bóng tennis" là các loại. Loại "bàn" bao gồm: bàn làm việc, bàn ăn, bàn học, bàn cafe, bàn máy.

CHÚ THÍCH 1: Các loại thường là các biến mục tiêu và được chỉ định bởi một tên.

3.3.2

Cụm (cluster)

Loại hình phần tử tự động sinh ra là một phần của bộ dữ liệu và có chung các đặc tính.

CHÚ THÍCH 1: Cụm không nhất thiết phải có tên.

3.3.3

Đặc tính (feature)

<học máy> Trọng số có thể đo lường được của một đối tượng hoặc sự kiện đối với một tập các đặc điểm.

CHÚ THÍCH 1: Các đặc tính có vai trò trong huấn luyện và dự đoán.

CHÚ THÍCH 2: Các đặc tính cung cấp cách thức mà máy có thể đọc được để mô tả các đối tượng liên quan. Vì thuật toán sẽ không quay trở lại chính các đối tượng hoặc sự kiện, nên biểu diễn đặc tính được thiết kế để chứa tất cả thông tin hữu ích.

3.3.4

Khoảng cách (distance)

<học máy> mức độ gần gũi giữa hai điểm theo không gian.

CHÚ THÍCH 1: Euclide, hoặc đường thẳng, khoảng cách thường được sử dụng trong học máy.

3.3.5

Không gắn nhãn (unlabelled)

Đặc tính của mẫu không bao gồm biến mục tiêu.

4 Thuật ngữ viết tắt

| AI | Artificial intelligence | Trí tuệ nhân tạo |

| API | Application programming interface | Giao diện lập trình ứng dụng |

| AUC | Area under the curve | Diện tích dưới đường cong |

| BM | Boltzmann machines | Máy Boltzmann |

| CapsNet | Capsule neural network | Mạng nơ-ron dạng viên |

| CG | Conjugate gradient | Độ dốc liên hợp |

| CNN | Convolutional neural network | Mạng nơ-ron tích chập |

| DBM | Deep Boltzmann machine | Máy Boltzmann sâu |

| DBN | Deep belief networks | Mạng tin tưởng sâu |

| DCNN | Deep convolutional neural network | Mạng nơ-ron tích chập sâu |

| FFNN | Feed forward neural network | Mạng nơ-ron tiến |

| FNR | False negative rate | Tỷ lệ âm tính giả |

| FPR | False positive rate | Tỷ lệ dương tính giả |

| GAN | Generative adversarial network | Mạng đối nghịch tạo sinh |

| GRU | Gated recurrent unit | Đơn vị cổng hồi quy |

| LSTM | Long short-term memory | Bộ nhớ ngắn - dài hạn |

| MAE | Mean absolute error | Sai số tuyệt đối trung bình |

| MDP | Markov decision process | Quá trình ra quyết định Markov |

| ML | Machine learning | Học máy |

| NN | Neural network | Mạng nơ-ron |

| NNEF | Neural network exchange format | Định dạng trao đổi mạng nơ-ron |

| NPV | Negative predictive value | Giá trị dự đoán âm tính |

| ONNX | Open neural network exchange | Trao đổi mạng nơ-ron mở |

| PCA | Principal component analysis | Phân tích thành phần chính |

| PHI | Personal or protected health information | Thông tin cá nhân hoặc thông tin sức khỏe được bảo vệ |

| PII | Personally identifiable information | Thông tin định danh cá nhân |

| PPV | Positive predictive value | Giá trị dự đoán dương tính |

| RBM | Restricted Boltzmann machines | Máy Boltzmann hạn chế |

| REST | Representational state transfer | Truyền đạt trạng thái biểu diễn |

| RNN | Recurrent neural network | Mạng nơ-ron hồi quy |

| ROC | Receiver operating characteristics | Đặc điểm hoạt động bên nhận |

| SGD | Stochastic gradient descent | Giảm độ dốc ngẫu nhiên |

| SVM | Support vector machine | Máy vec-to hỗ trợ |

| TNR | True negative rate | Tỷ lệ âm tính thật |

| TPR | True positive rate | Tỷ lệ dương tính thật |

5 Tổng quan

TCVN 13902:2023 định nghĩa ML là quá trình tối ưu hóa các tham số mô hình thông qua các kỹ thuật tính toán sao cho hành vi của mô hình phản ánh dữ liệu hoặc trải nghiệm. Kể từ đầu những năm 1940, mô hình nơ-ron (tức là mạng nơ-ron) và sự phát triển các chương trình máy tính có thể học hỏi từ dữ liệu đã được nghiên cứu. ML là lĩnh vực mở rộng với sự xuất hiện của các ứng dụng mới trong nhiều ngành lĩnh vực. Tiến trình này được kích hoạt bởi sự sẵn có lượng lớn dữ liệu và tài nguyên tính toán. Các phương pháp ML bao gồm mạng nơ-ron và học sâu.

Tiêu chuẩn TCVN 13902:2023 trình bày hệ sinh thái AI dưới dạng các lớp chức năng của nó và ML là một thành phần quan trọng của hệ sinh thái AI này. Hình 1 minh họa hệ thống ML phân chia mô hình thành các thành phần, công cụ phần mềm, các kỹ thuật và dữ liệu.

Điều 6 của tiêu chuẩn này mô tả về các thành phần khác nhau của hệ thống ML.

Điều 7 của tiêu chuẩn này mô tả cách tiếp cận ML khác nhau và mô tả sự phụ thuộc của chúng vào dữ liệu huấn luyện.

Điều 8 của tiêu chuẩn này mô tả quy trình ML: các quy trình liên quan đến việc phát triển, triển khai và vận hành một mô hình ML.

Khoản 6.5 và Điều 7 đề cập nhiều hơn về các khía cạnh kỹ thuật so với các nội dung khác của tiêu chuẩn. Người đọc càng có tảng kỹ thuật vững chắc càng hiểu rõ hơn về nội dung này của tiêu chuẩn.

6 Hệ thống học máy

6.1 Tổng quan

Hình 1 mô tả các phần tử của hệ thống ML. Chúng phác họa vai trò và các chức năng học máy cụ thể có thể được thực thi bởi các thực thể khác nhau, (ví dụ các nhà cung cấp khác nhau). Các ví dụ đưa ra trong Hình 1 không có nghĩa là bao hàm một danh sách đầy đủ. Các nội dung trong mục này sẽ giải thích thêm về từng phần của Hình 1.

Hình 1 - Các phần tử của hệ thống ML

Trong Hình 1, các phần tử phụ của mô hình phát triển và sử dụng có thể xem như cách tiếp cận theo lớp, tức là các ứng dụng được xây dựng từ các mô hình được sử dụng để giải quyết các tác vụ. Mô hình phát triển và sử dụng lại phụ thuộc vào các công cụ, kỹ thuật phần mềm và dữ liệu.

Một hệ thống ML có thể gồm một vài mô hình ML được sử dụng kết hợp. Các thành phần hệ thống có thể được mô tả theo đầu vào, đầu ra, mục đích và chức năng của chúng. Các thành phần có thể được kiểm tra một cách độc lập.

Các mô hình ML khi được triển khai sẽ tạo ra các đầu ra như dự đoán hoặc quyết định. Mô hình huấn luyện trước là một mô hình ML đã được huấn luyện trước đó. Trong một số trường hợp, mô hình đã phát triển có thể áp dụng cho một tác vụ tương tự trong một lĩnh vực khác. Học chuyển giao là một kỹ thuật để sửa đổi mô hình ML được huấn luyện trước để thực hiện một tác vụ liên quan khác.

Trong tiêu chuẩn này, ứng dụng đề cập đến cả mục đích sử dụng của một hoặc nhiều mô hình ML và phần cụ thể của phần mềm triển khai mục đích sử dụng đó. Các mô hình ML thường được tích hợp với các thành phần phần mềm khác để tạo ra ứng dụng. Các ứng dụng sử dụng ML khác nhau về loại dữ liệu đầu vào mà chúng xử lý và loại tác vụ mà chứng thực hiện. Trong một số ứng dụng, ML đưa ra các dự đoán hoặc quyết định cấp cao, trong khi ở các ứng dụng khác, ML cung cấp câu trả lời cho các vấn đề được xác định mang tính hẹp hơn.

Sự khác biệt về dữ liệu đầu vào và tác vụ, cũng như các yếu tố như tùy chọn triển khai, độ chính xác và độ tin cậy, dẫn đến các thiết kế ứng dụng khác nhau. Các ứng dụng AI có thể sử dụng các thiết kế tùy chỉnh độc quyền hoặc theo các mẫu thiết kế riêng cho lĩnh vực ứng dụng.

Logic của việc ứng dụng là cung cấp thông tin theo định dạng của dữ liệu đầu vào, dữ liệu đầu ra, khả năng chuyển đổi, cũng như luồng dữ liệu giữa các mô hình ML đang sử dụng. Trong mọi trường hợp, việc lựa chọn thuật toán ML và kỹ thuật chuẩn bị dữ liệu được điều chỉnh cho phù hợp với các tác vụ của ứng dụng.

6.2 Tác vụ

6.2.1 Yêu cầu chung

Thuật ngữ "tác vụ" đề cập đến các hành động cần thiết để đạt được một mục tiêu cụ thể. Trong ML điều này ngụ ý xác định một vấn đề cần giải quyết bằng mô hình ML. Một hoặc nhiều tác vụ ML có thể được xác định cho một ứng dụng ML. Thay vì giải quyết vấn đề đặt ra bằng cách sử dụng một chức năng cụ thể biểu thị dưới dạng một tập các bước thực hiện bằng mã chương trình phần mềm, vấn đề xác định được giải quyết bằng cách áp dụng mô hình ML được huấn luyện để làm việc với dữ liệu sản xuất.

Một cách hiệu quả, mô hình ML được huấn luyện thực hiện một hàm mục tiêu gần đúng với hàm giả định mà lập trình viên viết ra để giải quyết vấn đề.

Thiết lập tác vụ ML liên quan đến việc xác định vấn đề, định dạng dữ liệu và các tính năng.

Các tác vụ được mô tả trong các điều khoản con sau đây là các ví dụ nhưng không đầy đủ.

6.2.2 Hồi quy

Các tác vụ hồi quy bao gồm dự đoán một biến liên tục bằng cách tìm một hàm phù hợp nhất với một bộ dữ liệu huấn luyện. Trong một tác vụ hồi quy, mô hình hồi quy được huấn luyện đại diện cho một không gian tùy chỉnh. Khi mô hình được huấn luyện áp dụng cho một đối tượng dữ liệu sản xuất mới, các đối tượng được chỉ định vào không gian tùy chính xác định bởi mô hình hồi quy được huấn luyện.

Hồi quy chủ yếu được sử dụng để dự đoán các giá trị số của một quy trình trong thế giới thực dựa trên các phép đo hoặc quan sát trước đó trong cùng một quy trình. Các trường hợp sử dụng hồi quy bao gồm:

- dự đoán giá cả thị trường chứng khoán;

- dự đoán độ tuổi của người xem video phát trực tuyến;

- dự đoán lượng kháng nguyên dành riêng cho tuyến tiền liệt trong cơ thể dựa trên các đánh giá lâm sàng khác nhau.

6.2.3 Phân loại

Các tác vụ phân loại bao gồm dự đoán việc gán một thực thể dữ liệu đầu vào đến một danh mục hoặc loại hình xác định. Phân loại có thể là nhị phân (tức là đúng hoặc sai), đa loại (tức là một trong một vài khả năng) hoặc đa nhãn (tức là bất kỳ số nào ngoài khả năng). Ví dụ: phân loại có thể được sử dụng để dự đoán xem một đối tượng trong ảnh là mèo hay chó hay thậm chí là một loài hoàn toàn khác. Các loại thường là một tập hợp rời rạc và không có thứ tự, do đó bài toán không thể định hình thành một tác vụ hồi quy. Ví dụ: chẩn đoán y tế về một tập các triệu chứng có thể {đột quỵ, dùng thuốc quá liều, co giật}, không theo thứ tự đối với các giá trị của loại và không có sự thay đổi liên tục từ loại này sang loại khác.

Các trường hợp sử dụng để phân loại gồm:

- Phân loại tài liệu và lọc thư rác email, trong đó các tài liệu được nhóm thành nhiều loại. Chẳng hạn, bộ lọc thư rác sử dụng hai loại, cụ thể là "thư rác" và "không phải thư rác";

- Phân loại từ mẫu vật. Ví dụ: một mô hình phân loại ML có thể dự đoán loài hoa khi được cung cấp dữ liệu chỉ định chiều dài và chiều rộng của đài hoa cũng như chiều dài và chiều rộng của cánh hoa;

- Phân loại hình ảnh. Với một tập hợp hình ảnh (ví dụ: đồ nội thất), hệ thống ML có thể được sử dụng để nhận dạng và đặt tên cho các đối tượng được hiển thị trong các hình ảnh đó.

6.2.4 Phân cụm

Tác vụ phân cụm gộp các thực thể dữ liệu đầu vào thành nhóm. Không giống như tác vụ phân loại, các loại không được xác định trước trong các tác vụ phân cụm mà được xác định như một phần của quá trình phân cụm. Phân cụm có thể được sử dụng như một bước chuẩn bị dữ liệu để xác định dữ liệu đồng nhất để sau đó có thể sử dụng làm dữ liệu huấn luyện cho quá trình học máy có giám sát. Phân cụm cũng có thể được sử dụng để phát hiện các giá trị ngoại lệ hoặc bất thường bằng cách xác định các thực thể dữ liệu đầu vào không giống các mẫu khác. Các ví dụ về ứng dụng của tác vụ phân cụm bao gồm sắp xếp hoặc tổ chức các tệp.

6.2.5 Phát hiện bất thường

Phát hiện bất thường bao gồm xác định các thực thể dữ liệu đầu vào không tuân thủ mẫu dự kiến. Phát hiện bất thường có thể hữu ích cho các ứng dụng như phát hiện gian lận hoặc các hoạt động bất thường. Để phát hiện sự bất thường, mô hình ML dự đoán liệu một thực thể dữ liệu đầu vào có phải là đặc thù từ một nơi phân phối đã biết hay không.

6.2.6 Giảm chiều dữ liệu

Giảm chiều dữ liệu bao gồm giảm số lượng đặc tính hoặc kích thước trên mỗi mẫu trong khi vẫn giữ lại hầu hết các thông tin hữu ích.

Giảm chiều dữ liệu có thể tăng cường các đặc tính hữu ích nhất của bộ dữ liệu và do đó giảm thiểu chi phí tính toán.

Giảm chiều dữ liệu làm giảm bớt các tác động kém lý tưởng khác nhau trong việc giữ lại quá nhiều đặc tính, được gọi chung là "lời nguyền của số chiều". Giảm chiều dữ liệu cũng hữu ích cho việc khai phá dữ liệu và phân tích mô hình.

Các phương pháp giảm chiều dữ liệu là không giám sát, giám sát hoặc bán giám sát [1].

6.2.7 Các tác vụ khác

Có nhiều tác vụ khác có mục tiêu và đầu ra mong mong muốn khác nhau. Các tác vụ này có thể dành riêng cho những ứng dụng nhất định. Ví dụ về các tác vụ khác bao gồm phân đoạn ngữ nghĩa của văn bản hoặc hình ảnh, dịch máy, nhận dạng hoặc tổng hợp lời nói, bản địa hóa và tạo ảnh đối tượng.

Trong lập kế hoạch, tác vụ là tối ưu hóa chuỗi hành động từ một hoặc nhiều tác từ thông qua việc quan sát trạng thái môi trường.

Bất chấp sự đa dạng của chúng, một số khái niệm đã được xây dựng để tạo ra mối liên hệ giữa một số tác vụ khác này. Dự đoán có cấu trúc, tương ứng với các tác vụ trong đó đầu ra dự kiến của mô hình là một đối tượng có cấu trúc trái ngược với giá trị đơn lẻ là một trong những khái niệm như vậy.

Dự đoán có cấu trúc yêu cầu các phương pháp tính toán có thể tính đến các quy tắc ở đầu ra, bằng cách mô hình hóa chúng một cách tường minh hoặc bằng cách cùng dự đoán toàn bộ cấu trúc với một mô hình để mô hình các quy tắc bên trong. Các trường hợp sử dụng cho dự đoán có cấu trúc bao gồm:

- xây dựng cây phân tích cú pháp cho câu văn của ngôn ngữ tự nhiên;

- dịch một câu từ ngôn ngữ này sang ngôn ngữ khác;

- dự đoán cấu trúc protein;

- phân đoạn ngữ nghĩa của một hình ảnh.

6.3 Mô hình

TCVN 13902:2023 điều 3.2.11 định nghĩa mô hình ML là cấu trúc toán học tạo ra suy luận hoặc dự đoán dựa trên dữ liệu hoặc thông tin đầu vào. Mô hình ML bao gồm cấu trúc dữ liệu và phần mềm để xử lý cấu trúc, cả hai đều được xác định bởi thuật toán ML được chọn. Mô hình được cấu hình có đầu vào và đầu ra cần thiết để giải quyết bài toán đã cho.

Mô hình được trang bị (còn được gọi là "được huấn luyện") để thể hiện các đặc tính thống kê có liên quan của dữ liệu huấn luyện. Thông qua quá trình huấn luyện, mô hình "học" cách giải quyết vấn đề đối với dữ liệu đào tạo với mục tiêu áp dụng tri thức thu lượm được vào trong các ứng dụng thế giới thực.

Các mô hình ML tạo ra kết quả gần đúng với các giải pháp tối ưu. Các thuật toán ML sử dụng các phương pháp tối ưu thống kê để thực hiện phép ước lượng gần đúng. Ánh xạ kết quả từ đầu vào đến đầu ra của mô hình phản ánh các mẫu đã học được từ dữ liệu huấn luyện. Các mẫu có thể có mối liên hệ tương quan, mối quan hệ nhân quả hoặc danh mục các đối tượng của dữ liệu. Mô hình ML là kết quả của dữ liệu huấn luyện được sử dụng. Do đó, nếu dữ liệu được sử dụng không đầy đủ hoặc phản ánh những định kiến xã hội cố hữu, thì hiệu năng mô hình cũng sẽ phản ánh điều đó. Do đó, cần cẩn thận với các bộ dữ liệu được sử dụng để huấn luyện các mô hình. Logic được tạo ra trong quá trình học máy và thể hiện bởi mô hình được huấn luyện không được chỉ định bởi lập trình viên mà được phát triển thông qua các hoạt động huấn luyện.

Để xem mô hình hoạt động tốt hay không nó thì nó cần được đánh giá bằng sử dụng các chỉ số đánh giá.

Tái huấn luyện bao gồm việc cập nhật một mô hình đã được huấn luyện bằng cách huấn luyện nó với các dữ liệu huấn luyện khác nhau. Nó có thể cần thiết do nhiều yếu tố, bao gồm việc thiếu dữ liệu huấn luyện lớn, dịch chuyển về dữ liệu và khái niệm.

Nếu có sự dịch chuyển trong dữ liệu, độ chính xác dự đoán của mô hình giảm dần theo thời gian do những thay đổi về đặc tính thống kê của dữ liệu sản xuất. Trong trường hợp này, mô hình cần được tái huấn luyện với dữ liệu huấn luyện mới thể hiện tốt hơn cho dữ liệu sản xuất.

Trong dịch chuyển về khái niệm, ranh giới quyết định dường như di chuyển, điều này làm giảm độ chính xác của các dự đoán mặc dù dữ liệu không thay đổi. Trong trường hợp dịch chuyển về khái niệm các biến mục tiêu trong dữ liệu huấn luyện cần được dán nhãn lại và mô hình cần được tái huấn luyện.

Tái huấn luyện cũng có thể xảy ra cho các mục đích như học chuyển giao, tối ưu hóa hoặc sửa đổi mô hình ML.

Một số mô hình có thể sẵn có, sau đó có thể được tái huấn luyện và tối ưu hóa cho trường hợp sử dụng cụ thể hoặc được sử dụng nguyên trạng. Ví dụ có thể là một mô hình dịch máy thương mại tái huấn luyện để sử dụng cho việc dịch các văn bản pháp lý.

Học liên tục là một trường hợp đặc biệt của tái huấn luyện trong đó hiệu năng của mô hình liên tục phát triển, là kết quả của việc mô hình được huấn luyện liên tục bằng dữ liệu sản xuất. Trong những trường hợp như vậy, có thể cần phải liên tục theo dõi hiệu năng của mô hình hoặc triển khai "đường ray bảo vệ" đối với hành vi có thể chấp nhận được đối với mô hình.

6.4 Dữ liệu

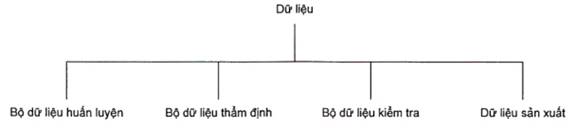

Hình 2 là sơ đồ dạng cào cho thấy khái niệm dữ liệu được phân chia thành bốn loại tách biệt nhau:

a) Bộ dữ liệu huấn luyện, dùng để ước lượng các tham số của mô hình đề cử;

b) Bộ dữ liệu thẩm định, còn được gọi là bộ dữ liệu phát triển tùy thuộc vào lĩnh vực AI (ví dụ: trong xử lý ngôn ngữ tự nhiên), được sử dụng để chọn mô hình tốt nhất theo tiêu chí về hiệu năng;

c) Bộ dữ liệu kiểm tra, dùng để kiểm tra khả năng khái quát hóa của mô hình và xác định hiệu năng của mô hình đối với dữ liệu trong tương lai;

d) Dữ liệu sản xuất, bao gồm dữ liệu vận hành được mô hình sử dụng để dự đoán. Phân bố của dữ liệu sản xuất có thể khác với dữ liệu huấn luyện, thẩm định và kiểm tra.

Bộ dữ liệu huấn luyện, thẩm định và kiểm tra có thể được bổ sung bằng dữ liệu mô phỏng và dữ liệu có nhiễu.

Hình 2 - Sơ đồ khái niệm: Dữ liệu và bộ dữ liệu

Các loại dữ liệu khác nhau này có thể bao gồm dữ liệu đầu vào đứng riêng hoặc dữ liệu đầu vào liên kết với nhãn (dữ liệu đầu ra dự kiến). Dữ liệu thẩm định và kiểm tra thường được gắn nhãn, dữ liệu sản xuất thường không được gắn nhãn. Đối với dữ liệu huấn luyện, nó phụ thuộc vào cách tiếp cận ML: nó có thể không gắn nhãn, được gắn nhãn một phần hoặc gắn nhãn đầy đủ. Dữ liệu huấn luyện được gắn nhãn cho phép thuật toán ML xác định mối quan hệ thống kê giữa các biến đầu vào và biến mục tiêu. Dữ liệu huấn luyện chưa được gắn nhãn cho phép thuật toán ML xác định các mối tương quan và cấu trúc thống kê bên trong dữ liệu đầu vào.

Dữ liệu kiểm tra và thẩm định đều được sử dụng với các phép đo hiệu năng thống kê (được thảo luận trong 6.5.5) nhưng cách sử dụng của chúng khác nhau: dữ liệu thẩm định sử dụng để điều chỉnh siêu tham số, dữ liệu kiểm tra để đánh giá mô hình. Mục đích của dữ liệu thẩm định là để xác minh rằng mô hình được huấn luyện sẽ thực hiện hoặc khái quát hóa tốt đối với dữ liệu sản xuất. Các mô hình được huấn luyện không khái quát hóa tốt được gọi là "quá phù hợp" (đối với dữ liệu huấn luyện).

Lưu ý rằng việc sử dụng thuật ngữ dữ liệu kiểm tra được giới hạn cho các quy trình dành riêng cho ML và khác với việc sử dụng thuật ngữ này trong ngữ cảnh kiểm tra và thẩm định một hệ thống tích hợp sử dụng các thành phần ML, trong đó đề cập đến bất kỳ dữ liệu nào được sử dụng cho mục đích xác minh và thẩm định mà không có mối liên hệ cụ thể nào với ML. Cũng lưu ý rằng sử dụng một ML cụ thể với thuật ngữ dữ liệu thẩm định không liên quan đến quy trình xác minh và thẩm định vì nó gắn liền với phát triển mô hình.

Để áp dụng các quy trình ML một cách tin cậy, dữ liệu huấn luyện, thẩm định và kiểm tra cần phải tách biệt. Các tập huấn luyện, thẩm định và kiểm tra có thể được lấy từ cùng một bộ dữ liệu bằng cách sử dụng phân tách dữ liệu hoặc chúng có thể được thu thập riêng rẽ. Trong một cấu hình lý tưởng, tất cả chúng đều có cùng phân phối thống kê, nhưng tùy thuộc vào trường hợp sử dụng và cách tiếp cận ML mà chúng có thể cần xử lý khác nhau.

Để đánh giá trung thực mô hình được huấn luyện, dữ liệu kiểm tra cần phải có phân bố càng giống với dữ liệu sản xuất càng tốt.

Dữ liệu sản xuất chỉ được nhìn thấy bởi mô hình sau khi triển khai. Nói chung, để mô hình đưa ra dự đoán chính xác thì dữ liệu sản xuất cần phải có phân bố tương tự như dữ liệu huấn luyện và thẩm định, mặc dù tồn tại các kỹ thuật có thể làm giảm bớt sự suy biến trong trường hợp có sự khác biệt.

Theo thời gian, phân bố dữ liệu sản xuất có thể dịch chuyển, điều này có thể yêu cầu mô hình phải được tái huấn luyện trên dữ liệu mới. Trong trường hợp mô hình cần tự động thích ứng với các mẫu mới trong dữ liệu sản xuất, mô hình có thể được tái huấn luyện liên tục bằng cách tận dụng thông tin thu được từ dữ liệu sản xuất. Những trường hợp như vậy được thảo luận trong 6.3.

6.5 Công cụ

6.5.1 Tổng quan

Việc tạo mô hình ML sử dụng các công cụ được phân loại là chuẩn bị dữ liệu, thuật toán ML, phương pháp tối ưu hóa và chỉ số đánh giá. Hiệu năng của mô hình ML được đánh giá thông qua các công cụ tạo chỉ số đánh giá.

Việc tạo mô hình ML thường yêu cầu khối lượng công việc tính toán hiệu năng cao do nhu cầu tính toán và việc sử dụng bộ dữ liệu đào tạo lớn. Hiệu suất điện toán và lưu trữ cũng có thể ảnh hưởng đến tốc độ phát triển và đào tạo các mô hình ML.

Những thách thức cơ bản với ML bao gồm phân tích thống kê, thiết kế thuật toán và tối ưu hóa. Phân tích thống kê liên quan đến các nguyên tắc của mô hình toán học bắt nguồn từ dữ liệu đào tạo. Thiết kế thuật toán là cách triển khai các kỹ thuật thuật toán được sử dụng để xây dựng mô hình ML. Tối ưu hóa một mô hình ML nhất định cũng là một vấn đề quan trọng trong việc triển khai ML. Một thách thức nữa là hiểu được tiềm năng và khả năng của ML. Nó làm cho dữ liệu được tái tạo, dễ truy cập, giải quyết các lỗi và sự mất cân bằng tồn tại trong nhiều trường hợp.

6.5.2 Chuẩn bị dữ liệu

Chuẩn bị dữ liệu được thảo luận trong 8.3.

6.5.3 Các loại thuật toán ML

6.5.3.1 Yêu cầu chung

Việc lựa chọn thuật toán ML xác định cấu trúc tính toán của mô hình ML và phương pháp đào tạo của nó.

Các thuật toán có thể được sử dụng cho các mục đích ML khác nhau, bao gồm:

- thuật toán biểu diễn thông tin có thể tham gia vào giai đoạn chuẩn bị dữ liệu. Điều này liên quan đến kỹ thuật trích chọn đặc tính;

- thuật toán sử dụng để tạo mô hình ML.

Mối quan hệ giữa các thuật toán ML và các mô hình ML có thể được minh họa bằng cách xem xét việc giải hàm tuyến tính một biến y = θ0 + θ1x trong đó y là đầu ra hoặc kết quả, x là đầu vào, θ0 là giá trị chặn (giá trị của y trong đó x = 0) và θ1 là trọng số. Trong ML, quá trình xác định giá trị chặn và trọng số cho một hàm tuyến tính được gọi là hồi quy tuyến tính. Nếu một hàm tuyến tính đơn biến (y = θ0 + θ1x) đã được huấn luyện bằng cách sử dụng hồi quy tuyến tính, mô hình kết quả có thể là y = 3 + 7x.

Hình 3 cho thấy các ví dụ về các loại thuật toán ML khác nhau.

Hình 3 - Ví dụ về một số loại hình thuật toán ML

Việc lựa chọn thuật toán ML thường không đủ để xác định cấu trúc của mô hình ML và phương pháp huấn luyện nó. Đối với nhiều thuật toán, siêu tham số sẽ được chọn.

Siêu tham số là đặc điểm của thuật toán ML ảnh hưởng đến quá trình học tập của nó. Chúng có thể được sử dụng trong các quy trình để giúp ước lượng các tham số mô hình. Ví dụ về siêu tham số cho mạng nơ-ron bao gồm số lượng lớp mạng, độ rộng của mỗi lớp và dạng loại năng được kích hoạt. Một cách tiếp cận thực tế để xác định bộ siêu tham số tối ưu trong số các tổ hợp có thể là tiến hành tìm kiếm ngẫu nhiên với các điều kiện của hàm ràng buộc và đo lường hiệu năng dựa trên bộ dữ liệu thẩm định. Bước này được gọi là lựa chọn mô hình, hoặc điều chỉnh siêu tham số.

6.5.3.2 Mạng nơ-ron

6.5.3.2.1 Yêu cầu chung

Mạng nơ-ron (NN) cố gắng mô phỏng khả năng thông minh trong việc quan sát, học hỏi, phân tích và ra quyết định cho các vấn đề phức tạp. Do đó thiết kế của NN lấy cảm hứng từ cách các nơ-ron được liên kết trong bộ não của con người và động vật. Chúng sử dụng các mạng nhiều lớp được cấu tạo từ các đơn vị tính toán đơn giản (hay "nơ-ron"). Trong các NN này, mỗi đơn vị kết hợp một tập các giá trị đầu vào để tạo ra một giá trị đầu ra để chuyển đến các nơ-ron kế tiếp theo luồng xử lý. Cấu trúc của một NN bao gồm các phần tử xử lý được liên kết với nhau. Một mạng các nút (hoặc nơ-ron) được liên kết bởi các cạnh có trọng số. Dạng mạng đơn giản nhất bao gồm một hoặc nhiều nơ-ron đầu vào chấp nhận một hoặc nhiều đặc tính của dữ liệu đầu vào, cũng như một lớp đầu ra bao gồm một hoặc nhiều nơ-ron.

Mỗi nơ-ron có thể chấp nhận một hoặc nhiều đều vào từ lớp trước, đầu ra của nó được cung cấp bởi hàm kích hoạt, thường phụ thuộc phi tuyến vào tổ hợp trọng số của các đầu vào từ lớp trước. NN "học" bằng cách huấn luyện nó với các đầu vào đã biết, so sánh đầu ra thực tế với đầu ra dự kiến và sử dụng sai lệch giữa chúng để điều chỉnh các trọng số.

Các lớp ẩn có thể tồn tại giữa các lớp đầu ra và đầu vào của NN, trong trường hợp này nó được gọi là phân loại tri giác đa lớp hoặc NN đa lớp. Mạng nơ-ron sâu hoặc học sâu đề cập cụ thể đến các mạng nơ-ron có nhiều lớp ẩn. Học sâu là một cách tiếp cận để tạo ra các biểu diễn phân cấp phong phú thông qua việc đào tạo NN với nhiều lớp ẩn. Quá trình này cho phép mạng nơ-ron từng bước tinh chỉnh cho đến đầu ra cuối cùng. Học sâu có thể giảm hoặc loại bỏ các đòi hỏi về đặc tính kỹ thuật vì các đặc tính phù hợp nhất được xác định tự động.

NN có thể phân thành ba loại chung: phân biệt, tạo sinh và lai (kết hợp của hai loại trước).

NN có thể xem xét trong cách tiếp cận theo thuyết liên kết. Thuyết này sử dụng một mạng lưới các đơn vị liên kết với nhau, thường là các đơn vị tính toán đơn giản [2]. Hành vi của mạng có thể được tinh chỉnh bằng cách sửa đổi các trọng số liên quan đến mỗi liên kết như mô tả ở trên và có được thông qua huấn luyện. Các nút của mạng xử lý thông tin ở chế độ song song.

Học sâu có thể yêu cầu thời gian và tài nguyên tính toán đáng kể. ML NN thường yêu cầu một lượng công suất tính toán và bộ nhớ đáng kể để hoạt động. Giảm độ phức tạp của mô hình có thể đạt được lợi ích để sử dụng các mạng này trên thiết bị di động và thiết bị nhúng. Thời gian chạy và mức tiêu thụ năng lượng có thể được giảm thiểu, trong một số trường hợp việc giảm thiểu này cho phép NN chạy theo thời gian thực trên thiết bị di động mà không cần dựa vào dịch vụ đám mây. Nén trọng số hoặc nén kiến trúc có thể làm giảm một cách thích đáng độ phức tạp của mô hình trong khi vẫn gần như duy trì hiệu năng như nhau.

6.5.3.2.2 Mạng nơ-ron tiến

Mạng nơ-ron tiến (FFNN) là kiến trúc NN đơn giản nhất. Chúng cung cấp thông tin từ lớp đầu vào đến lớp đầu ra chỉ theo một hướng và không có liên kết giữa các nơ-ron trong một lớp cụ thể. Hai lớp liền kề thường được "liên kết đầy đủ", trong đó mỗi nơ-ron trong một lớp có liên kết với từng nơ-ron trong lớp tiếp theo. Mỗi liên kết có một trọng số liên quan đến nó. FFNN thường được huấn luyện thông qua việc sử dụng lan truyền ngược với dữ liệu huấn luyện được gắn nhãn, trong đó mỗi mẫu được gắn nhãn với sự thật nền đối với giá trị mong muốn của dữ liệu đầu ra. Sự sai khác giữa đầu ra thực tế của FFNN và sự thật nền được gọi là độ lệch [3]. Lan truyền ngược liên quan đến việc sử dụng độ lệch ở ở lớp đầu ra để điều chỉnh trọng số cho các liên kết từ các lớp kế tiếp trước đó. Nó thường được sử dụng cùng với giảm dần độ dốc [4].

6.5.3.2.3 Mạng nơ-ron hồi quy

6.5.3.2.3.1 Yêu cầu chung

Mạng nơ-ron hồi quy (RNN)[5] là NN hướng tới xử lý các đầu vào tuần tự xuất hiện theo chuỗi tuần tự trong đó thứ tự của các đầu vào trong chuỗi có ý nghĩa quan trọng. Ví dụ về các đầu vào như vậy bao gồm các chuỗi động như luồng âm thanh và video, nhưng cũng có các chuỗi tĩnh như văn bản hoặc thậm chí là hình ảnh đơn lẻ. Về nguyên tắc RNN có thể sử dụng trong nhiều lĩnh vực, vì hầu hết các dạng dữ liệu không có tính tuần tự theo thời gian (nghĩa là không giống như âm thanh hoặc video) để có thể được biểu diễn dưới dạng một chuỗi. Tại một thời điểm hình ảnh hoặc chuỗi văn bản có thể được cung cấp một pixel hoặc một ký tự. Do đó trọng số phụ thuộc vào thời gian được sử dụng cho những gì xảy ra trước đó trong chuỗi, chứ không phải thực sự từ những gì xảy ra trước đó theo thời gian.

RNN có đặc tính trạng thái bị ảnh hưởng bởi việc học trong quá khứ. Đầu vào dự kiến thực hiện các lần truyền tuần tự theo thời gian và RNN lưu giữ thông tin từ mỗi một lần truyền để sử dụng trong lần truyền sau, tức là RNN có bộ nhớ. Do đó trong RNN, các nơ-ron trong một lớp không chỉ có các liên kết có trọng số từ các nơ-ron ở lớp trước cho lần truyền hiện tại, chúng còn có đầu vào từ các nơ-ron ở các lần truyền trước đó. RNN được sử dụng rộng rãi trong nhận dạng lời nói, dịch máy, dự báo theo chuỗi thời gian và nhận dạng hình ảnh. Nói chung, RNN là một lựa chọn tốt để cải thiện hoặc hoàn chỉnh thông tin, chẳng hạn như thực hiện nó một cách tự động.

RNN rất phù hợp để xử lý dữ liệu đầu vào tuần tự có độ dài thay đổi hoặc xuất dữ liệu đầu ra tuần tự có độ dài thay đổi. Các loại RNN phổ biến bao gồm mạng bộ nhớ ngắn - dài hạn (LSTM) và mạng đơn vị cổng hồi quy hồi quy có kiểm soát (GRU), một biến thể đơn giản hơn của LSTM.

6.5.3.2.3.2 Mạng bộ nhớ ngắn - dài hạn

Mạng bộ nhớ ngắn - dài hạn (LSTM) là một dạng RNN được thiết kế cho các bài toán yêu cầu ghi nhớ thông tin với sự chênh lệch về thời gian dài và ngắn, khiến chúng phù hợp để học trên các liên kết dài hạn. Nó dùng để giải quyết vấn đề độ dốc biến mất trong RNN liên quan đến lan truyền ngược. Mỗi tế bào LSTM có bộ nhớ trong và trạng thái ẩn. RNN phụ thuộc vào việc sử dụng lan truyền ngược trong quá trình đào tạo nhưng cách tiếp cận này có thể gặp phải vấn đề độ dốc biến mất hoặc vấn đề độ dốc bùng phát [6]. Trong quá trình đào tạo, các trọng số RNN được cập nhật dựa trên đạo hàm riêng của hàm lỗi trong mỗi lần huấn luyện lặp. Đạo hàm có thể rất nhỏ, dẫn đến RNN không thể huấn luyện một cách hiệu quả hoặc có thể rất lớn, dẫn đến RNN rất không ổn định.

Một LSTM được thiết kế để học các phụ thuộc dài hạn và có kiến trúc dựa trên sự kết hợp của các nơ-ron, với một ô (có khả năng bộ nhớ), một cổng đầu vào, một cổng đầu ra và một cổng quên. Ô nhớ được liên kết với mỗi nơ-ron chứa thông tin về trạng thái trước đó của nó. Chức năng của các cổng này là kiểm soát thông tin bằng việc chặn hoặc cho phép thông tin truyền đi. Cổng đầu vào xác định lượng thông tin từ lớp trước được lưu trữ trong ô. Cổng đầu ra ở đầu bên kia xác định số lượng trạng thái của ô được chuyển sang lớp tiếp theo. Cổng quên cho phép mạng xóa trạng thái bên trong của nó. Ví dụ: nếu đầu vào là một đoạn văn và bắt đầu bằng một câu mới, mạng có thể cần phải quên một số ký tự từ câu trước đó. Vì mỗi nơ-ron của LSTM có một trọng số riêng cho mỗi cổng nên nó phức tạp hơn các loại NN khác, kết quả là LSTM thường yêu cầu nhiều tài nguyên hơn để huấn luyện và vận hành. LSTM đã được chứng minh là có thể học các trình tự phức tạp, chẳng hạn viết như Shakespeare hoặc sáng tác nhạc.

6.5.3.2.4 Mạng nơ-ron tích chập

Mạng nơ-ron tích chập (CNN) là một loại NN bao gồm ít nhất một lớp tích chập để lọc thông tin hữu ích từ đầu vào. CNN chủ yếu được sử dụng để xử lý hình ảnh [7] và ghi nhãn video, nhưng cũng có thể áp dụng cho các loại đầu vào khác như âm thanh hoặc văn bản (đôi khi sử dụng các phiên bản hồi quy hoặc CNN hồi quy). Các kiểu kết nối của CNN để xử lý hình ảnh giống với tổ chức của vỏ não thị giác động vật. Trái ngược với RNN, mỗi nơ-ron đặt trên một lớp nhất định của CNN chỉ được kết nối với các nơ-ron từ lớp trước đó và không được cung cấp thông tin về trạng thái trước đó của nó. Tập đầu vào của một nơ-ron nhất định được gọi là trường tiếp nhận của nó. Trong CNN, NN thường chứa các loại lớp khác nhau, bao gồm lớp tích chập và lớp tổng hợp. Mạng nơ-ron tích chập giả định rằng đầu vào của chúng có cấu trúc liên kết dạng lưới, như hình ảnh (lưới 2 chiều) hoặc chuỗi thời gian (lưới 1 chiều). Các lớp tích chập xử lý đầu vào của chúng dưới dạng vectơ hoặc ma trận (ví dụ: hình ảnh 2 chiều) và áp dụng tích chập cho đầu vào là tích vô hướng trượt hoặc tương quan chéo. Trong đó vectơ hoặc ma trận được gọi là hạt nhân áp dụng cho dữ liệu đầu vào. Một tích chập được thiết kế để trích xuất các đặc tính cụ thể từ đầu vào và tạo bản đồ đặc tính cho lớp tiếp theo trong CNN. Cách tiếp cận này có thể làm cho vị trí của CNN bất biến đối với các đặc tính trong dữ liệu đầu vào, là điều rất được mong đợi khi xử lý các hình ảnh trong thế giới thực.

Các lớp tổng hợp làm giảm kích thước của dữ liệu đầu vào của chúng ở phạm vi cục bộ (đối với một số lượng nhỏ đầu vào) hoặc toàn cục đối với tất cả các đầu vào từ lớp trước. Lớp tổng hợp lọc ra các chi tiết không quan trọng một cách hiệu quả. Nhiều lớp tích chập và tổng hợp có thể được sử dụng tuần tự để tạo ra kết quả tốt hơn.

Các lớp kết nối đầy đủ thường được sử dụng gần với đầu ra CNN. Việc triển khai CNN trong thế giới thực thường dán một FFNN vào đầu cuối để xử lý thêm dữ liệu, điều này cho phép trừu tượng hóa phi tuyến cao.

6.5.3.2.5 Tri giác có cấu trúc

Tri giác có cấu trúc là phần mở rộng của thuật toán tri giác sử dụng bởi NN. Các tri giác có cấu trúc sử dụng một lớp nơ-ron nhân nhiều lần kế tiếp nhau để dự đoán các phần khác nhau của đầu ra. Quy trình đào tạo tri giác có cấu trúc phản ánh thiết kế này: một biến mục tiêu đơn nhất được sử dụng để đánh giá nhiều dự đoán cùng một lúc.

6.5.3.2.6 Máy Boltzmann sâu

Máy Boltzmann (BM) là mạng các đơn vị nhị phân {0,1} bao gồm một tập hợp các đơn vị tường minh và một tập các đơn vị ẩn. Kết nối chỉ tồn tại giữa các đơn vị lân cận nhau. Kết nối là hai chiều và có khả năng học các phân bố xác suất chưa biết. Chúng rất hữu ích trong nhận dạng đối tượng hoặc lời nói. BM là một thuật toán tạo sinh.

Dạng BM đơn giản nhất được gọi là máy Boltzmann hạn chế (RBM). Khi nhiều lớp RBM được xếp chồng lên nhau nó được gọi là máy Boltzmann sâu (DBM). Mạng tin tưởng sâu (DBN) tương tự như DBM nhưng có các lớp nơ-ron (tức là liên kết một chiều).

6.5.3.2.7 Mạng dạng viên

Mạng dạng viên (CapsNet) là các NN triển khai định tuyến động có thể huấn luyện trên dữ liệu thưa. Mạng này cải thiện một số hạn chế của CNN bằng cách thay thế các nơ-ron bằng cấu trúc gọi là viên nang, bao gồm các tập nơ-ron đan xen chặt chẽ với nhau và được cập nhật đồng thời. Liên kết giữa các viên nang cũng được cải thiện để CapsNets có thể nắm bắt tốt hơn các mối quan hệ phân cấp và tạo các biểu diễn bậc cao hơn. CapsNets là một loại hình để phân biệt.

6.5.3.2.8 Mạng đối nghịch tạo sinh

Các mạng đối nghịch tạo sinh (GAN) là các NN chứa một hoặc nhiều bộ tạo sinh cố gắng tạo các mẫu đại diện tốt nhất cho bộ dữ liệu; và một hoặc nhiều bộ phân biệt cố gắng phân biệt các mẫu được tạo ra với các mẫu thực. Các thành phần bộ tạo sinh và bộ phân biệt được huấn luyện cùng nhau để cải thiện sự biểu đạt bên trong của mạng.

GAN có thể được sử dụng cho nhiều tác vụ khác nhau (ví dụ: phân loại), nhưng cũng có thể cho các mục đích khác như tạo dữ liệu nhân tạo hoặc thích ứng với lĩnh vực ứng dụng mới.

6.5.3.3 Mạng Bayes

Mạng Bayes là các mô hình đồ họa được sử dụng để tạo dự đoán về sự phụ thuộc giữa các biến. Chúng có thể được sử dụng để rút ra xác suất cho các nguyên nhân hoặc biến số có thể đóng góp vào kết quả. Quan hệ nhân quả này rất hữu ích trong các ứng dụng như chẩn đoán y khoa. Các mạng Bayesian cũng hữu ích cho việc phân tích dữ liệu, xử lý dữ liệu không đầy đủ và giảm thiểu sự xuất hiện mô hình quá phù hợp với dữ liệu. Mạng Bayes dựa trên xác suất Bayes: xác suất của một sự kiện được coi là mức độ tin tưởng vào sự kiện đó. Tồn tại nhiều phương pháp thống kê Bayes khác nhau có thể được sử dụng cùng với các mạng Bayesian để xác định quan hệ nhân quả hoặc thực hiện phân tích dữ liệu. Các mạng Bayesian thường sử dụng để biểu diễn đồ họa của các biến được gọi là đồ thị không tuần hoàn có hướng. Các biểu đồ này có đặc tính đi theo các liên kết giữa một biến x và các biến khác, biểu đồ sẽ không bao giờ quay trở lại x. Thông tin thêm về mạng Bayes có thể tìm thấy trong tài liệu tham khảo [8].

6.5.3.4 Thuật toán Naive Bayes

Thuật toán Naive Bayes là một kỹ thuật phân loại dựa trên định lý Bayes. Định lý xác định xác suất xảy ra của một sự kiện, dựa trên tri thức về các sự kiện liên quan trước đó. Điều này giúp cải thiện độ chính xác của việc xác định xem sự kiện có xảy ra hay không. Ví dụ, chẩn đoán một tình trạng y tế có thể được thực hiện chính xác hơn bằng cách xem xét lối sống của bệnh nhân, ví dụ như lười vận động so với chăm vận động. Với phân loại Naïve Bayes, người ta cho rằng các đặc tính của dữ liệu độc lập về mặt thống kê với nhau. Phương pháp phân loại này có ưu điểm là tương đối đơn giản và không dựa vào bộ dữ liệu quá lớn để huấn luyện.

6.5.3.5 Máy vectơ hỗ trợ

Máy vectơ hỗ trợ (SVM) là một phương pháp ML được sử dụng rộng rãi để phân loại và hồi quy. Bộ phân loại SVM đánh dấu các mẫu thành hai danh mục khác nhau và sau đó gán các thực thể dữ liệu đầu vào mới cho danh mục này hoặc danh mục kia. SVM là các thuật toán phân loại cận biên tối đa. Nó xác định một siêu phẳng để phân tách dữ liệu thành hai lớp, cung cấp khoảng cách tối đa giữa mặt phẳng phân loại và các điểm dữ liệu gần nhất. Các điểm gần ranh giới nhất được gọi là "vectơ hỗ trợ". Khoảng cách trực giao giữa các vectơ hỗ trợ và siêu phẳng là một nửa "lề" của SVM. Các SVM cũng sử dụng các hàm kernel để ánh xạ dữ liệu từ không gian đầu vào sang không gian có nhiều chiều hơn (đôi khi là vô hạn), trong đó siêu phẳng phân loại được áp dụng.

Việc đào tạo một SVM liên quan đến việc tối đa hóa đối tượng biên cho loại hình dữ liệu khác nhau nằm ở phía đối diện của siêu phẳng. SVM với "biên cứng" hiếm khi được sử dụng trong thực tế. Bộ phân loại biên cứng chỉ hoạt động nếu dữ liệu có thể phân tách tuyến tính trong không gian mà nó được nhúng vào. Ngay cả một mẫu đơn lẻ cũng có thể không tìm được một siêu phẳng phân tách. Ngược lại, các bộ phân loại có "biên mềm" cho phép các mẫu dữ liệu vi phạm biên (nghĩa là nằm ở phía bên kia của siêu phẳng). Các bộ phân loại biên mềm cố gắng đạt được mức cận biên tối đa trong khi hạn chế vi phạm biên. Phân loại dữ liệu chưa được gắn nhãn sử dụng trong dự đoán và nhận dạng mẫu là những ví dụ về ứng dụng của SVM.

Khi sử dụng một SVM để hồi quy thì mục tiêu ngược lại với phân loại SVM. Trong hồi quy SVM, mục tiêu là khớp càng nhiều càng tốt các thực thể dữ liệu bên trong biên và hạn chế vi phạm các vi phạm biên (tức là những mẫu bên ngoài biên).

6.5.3.6 Cây quyết định

Cây quyết định sử dụng cấu trúc cây để quyết định mã hóa các kết quả có thể xảy ra. Các thuật toán cây quyết định được sử dụng rộng rãi để phân loại và hồi quy. Cây được hình thành từ các nút quyết định và các nút lá. Mỗi nút quyết định có ít nhất hai nhánh, các nút lá đại diện cho quyết định hoặc phân loại cuối cùng. Nói chung, các nút được sắp xếp lần lượt theo quyết định đưa ra yếu tố dự đoán mạnh nhất. Dữ liệu đầu vào cần được chia thành các yếu tố khác nhau để xác định kết quả tốt nhất. Cây quyết định tương tự như lưu đồ trong đó tại mỗi nút quyết định, một câu hỏi có thể được đặt ra để xác định nhánh nào sẽ tiếp tục thực hiện.

6.5.4 Các phương pháp tối ưu hóa ML

6.5.4.1 Yêu cầu chung

Các phương pháp tối ưu hóa ML được sử dụng để khớp một mô hình ML với dữ liệu ML. Thách thức trong tối ưu hóa ML là tìm các tham số tối ưu của mô hình ML để giảm thiểu hàm mất mát đối với dữ liệu ML đã cho. Hầu hết các phương pháp sau đây đều dựa vào hàm mất mát (đôi khi được gọi là "chi phí") để xác định xem mô hình có hội tụ tới một giải pháp có thể chấp nhận được hay bị phân kỳ. Các phương pháp tối ưu hóa ML phổ biến được mô tả trong các điều khoản dưới đây.

Ngoài các phương pháp tối ưu hóa, các kỹ thuật khác có thể cải thiện cách mô hình ML phù hợp với dữ liệu. Một khía cạnh như vậy là việc lựa chọn một hàm mất mát tốt hơn. Ví dụ: quy tắc hóa là một kỹ thuật được sử dụng để giảm sự quá phù hợp và phương sai dự đoán cao bằng việc nêu các khái niệm mới trong về tổn thất. Nó hoạt động bằng cách xử phạt trong các mô hình phức tạp và ủng hộ mô hình mang tính tổng quát và kém chính xác hơn.

6.5.4.2 Các phương pháp giảm độ dốc

Giảm độ dốc là một kỹ thuật lặp để tìm giá trị nhỏ nhất của một hàm: khi cung cấp toàn bộ bộ dữ liệu dưới dạng một lô duy nhất, các tham số được cập nhật từng bước, theo cùng hướng với đạo hàm bậc nhất (độ dốc) của hàm. Giải pháp là tối ưu toàn cục khi hàm mục tiêu lồi. Khi các tham số cập nhật được tính toán thông qua các lô nhỏ hơn được chọn ngẫu nhiên thay vì trên toàn bộ bộ dữ liệu dưới dạng một lô duy nhất thì được gọi là giảm độ dốc ngẫu nhiên (SGD). SGD giảm chi phí tính toán trong nhưng có thể xảy ra rủi ro là đưa ra giải pháp tối thiểu hóa ở phạm vi cục bộ. Kích thước bước lặp của độ dốc được gọi là tốc độ học.

Các phương pháp mô-men đề ra tốc độ như một biến để biểu thị hướng và tốc độ của một tham số thay đổi trong không gian của nó; thao tác này duy trì ảnh hưởng của hướng cập nhật trước đó cho lần lặp lại tiếp theo. Phương pháp giảm sự gia tăng độ dốc Nesterov áp dụng khái niệm mô-men thích ứng để có được sự hội tụ nhanh hơn.

Điều chỉnh tốc độ học bằng cách thay đổi kích thước bước của mỗi lần cập nhật tham số sẽ cải thiện các phương pháp giảm dần độ dốc. Đây được gọi là tốc độ học thích ứng. Một ví dụ là AdaGrad (thuật toán độ dốc thích ứng) tự động điều chỉnh tốc độ học.

Thông tin dư thừa trong dữ liệu huấn luyện có thể dẫn đến sự hội tụ chậm với các phương pháp SGD. Độ dốc trung bình ngẫu nhiên duy trì một tham số để ghi lại tổng của các độ dốc mới nhất. Tổng này được cập nhật ngẫu nhiên trên mỗi lần lặp và thay thế độ dốc cũ bằng một độ dốc mới trong mỗi một chu kỳ. Kỹ thuật này nhằm giảm giá trị phương sai.

6.5.4.3 Phương pháp Newton

Phương pháp của Newton sử dụng ma trận đạo hàm bậc nhất (gradient) và bậc hai, còn được gọi là ma trận Hess để xấp xỉ hàm mục tiêu với hàm phương sai. Phương pháp của Newton làm khớp bề mặt cục bộ của vị trí hiện tại với một bề mặt phương sai; điều này trái ngược với phương pháp giảm độ dốc phù hợp với bề mặt cục bộ hiện tại với một mặt phẳng.

6.5.4.4 Độ dốc liên hợp

Phương pháp độ dốc liên hợp (CG) tính toán tích vectơ Hess mà không tính toán trực tiếp ma trận Hess như trong phương pháp Newton. CG tạo hướng tìm kiếm mới bằng cách chỉ sử dụng vectơ trước đó. Nó tránh được điểm phạt khi tính ma trận nghịch đảo Hess.

6.5.4.5 Quá trình Gauss

Quá trình Gaussian là một tập các biến ngẫu nhiên với các phân bố Gauss kết hợp nhất quán. Quá trình Gaussian dựa trên lý thuyết Bayes và học thống kê. Ưu điểm của nó là suy luận phi tham số linh hoạt và tương thích tốt với các yêu cầu tính toán phức tạp và lưu trữ lớn.

6.5.4.6 Khớp đường cong bình phương tối thiểu

Bình phương tối thiểu là kỹ thuật để khớp hàm đa thức với dữ liệu đã cho bằng cách giảm thiểu tổng bình phương của sự khác biệt giữa đầu ra của hàm đa thức và dữ liệu đã cho. Bậc của đa thức cần phù hợp với dữ liệu kiểm tra để đạt được kết quả tốt. Khớp đường cong bình phương tối thiểu có thể thực hiện đối với từng lô dữ liệu của bộ dữ liệu hoàn chỉnh hoặc theo cách đệ quy với các bộ dữ liệu đang phát triển.

6.5.4.7 Ước lượng khả năng cực đại

Ước lượng khả năng cực đại là một phương pháp để ước tính các tham số của phân bố xác suất bằng cách tối đa hóa hàm khả năng. Để xây dựng mô hình xác suất từ dữ liệu quan sát được, ước lượng khả năng cực đại chọn giả thuyết tối đa hóa khả năng xảy ra của dữ liệu quan sát được. Ở dạng tổng quát, nó không sử dụng bất kỳ kiến thức tiên nghiệm nào để ủng hộ một giả thuyết cụ thể. Các phương pháp ước lượng khả năng cực đại thường sử dụng phép lôgarit đối với khả năng xảy ra cho việc tính toán.

6.5.4.8 Tối đa hóa kỳ vọng

Tối đa hóa kỳ vọng là một phương pháp lặp đi lặp lại để tìm hiểu các tham số mô hình với các biến ẩn không thể quan sát được trong dữ liệu. Nó bao gồm sự xen kẽ giữa các bước kỳ vọng (ước lượng các biến ẩn dựa trên các tham số hiện tại) và các bước tối đa hóa (ước tính lại các tham số để tối ưu hóa khả năng xảy ra của dữ liệu với giá trị hiện tại của các biến ẩn đã cho) cho đến khi hội tụ.

6.5.5 Chỉ số đánh giá ML

6.5.5.1 Yêu cầu chung

Các tác vụ ML (xem trong 6.2) thường xác định các chỉ số đánh giá phù hợp. Hiểu trường hợp sử dụng đối với một mô hình là rất quan trọng để chọn các chỉ số đánh giá phù hợp. Có thể yêu cầu nhiều chỉ số để thể hiện đầy đủ mọi khóa cạnh của việc kiểm tra hiệu năng mô hình. Việc sử dụng một chỉ số duy nhất, thậm chí là chỉ số tổng hợp chẳng hạn như điểm số F1 sẽ gặp rủi ro nếu không kiểm tra kỹ lưỡng các kết quả cơ bản. Hơn nữa, sự mất cân bằng lớp trong dữ liệu đào tạo là một yếu tố gây nhiễu có thể làm sai lệch chỉ số khác nhau.

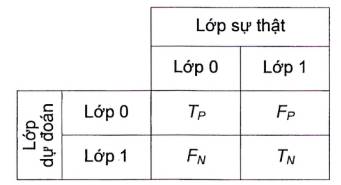

Nhiều chỉ số trong số đó, đặc biệt trong trường hợp phân loại, dựa trên các khái niệm về dương tính thật (TP, tương ứng với các mẫu đã được phát hiện chính xác), dương tính giả (FP, tương ứng với các mẫu đã được phát hiện trong khi lẽ ra chúng phải không được phát hiện), có), âm tính thật (TN, tương ứng với các mẫu không được phát hiện là chính xác) và âm tính giả (FN, tương ứng với các mẫu không được phát hiện trong khi lẽ ra chúng phải được phát hiện).

Có nhiều chỉ số khả dụng để thể hiện hiệu năng của các mô hình được huấn luyện, chẳng hạn như:

- Độ chính xác, đặc tính hoạt động máy thu (ROC), ma trận nhầm lẫn, độ chụm, độ thu hồi và điểm số F1 có thể được sử dụng để đánh giá các thuật toán phân loại;

- Sai số tuyệt đối trung bình (MAE), sai số bình phương trung bình, sai số tuyệt đối tương đối, sai số bình phương tương đối, sai số 0-1 trung bình và hệ số xác định là các thước đo phổ biến cho các mô hình hồi quy;

- Các chỉ số đánh giá cho các mô hình phân cụm bao gồm khoảng cách trung bình đến trung tâm cụm, khoảng cách trung bình đến trung tâm khác, số điểm và khoảng cách tối đa đến trung tâm cụm.

Các điều khoản dưới đây mô tả các ví dụ về các chỉ số như vậy và không có nghĩa là đầy đủ.

6.5.5.2 Độ chụm, độ thu hồi, độ nhạy và tính đặc trưng

Loạt chỉ số sau đây có thể được tính trực tiếp theo tỷ lệ giữa TP, FP, TN và FN:

- Tỷ lệ dương tính thật (TPR) là tỷ lệ của các dương tính thật (TP) trong số tất cả các dương tính thực tế (TP + FN). Phần bù của nó được gọi là tỷ lệ âm tính giả (FNR);

- Tỷ lệ âm tính thật (TNR) là tỷ lệ âm tính thực sự (TN) trong số tất cả các âm tính thực tế (TN + FP). Phần bù của nó được gọi là tỷ lệ dương tính giả (FPR);

- Giá trị dự báo dương tính (PPV) là tỷ lệ dương tính thật (TP) trong số tất cả các kết quả dương tính được dự đoán (TP + FP);

- Giá trị dự đoán âm tính (NPV) là tỷ lệ âm tính thật (TN) trong số tất cả các âm tính được dự đoán (TN + FN).

Vì chúng đưa ra các quan điểm bổ sung cho nhau, nên để đánh giá thì các số liệu này thường được sử dụng theo cặp: PPV và TPR, trong trường hợp đó chúng được gọi là độ chụm và độ thu hồi; hoặc trong trường hợp TPR và TNR chúng được gọi là độ nhạy và tính đặc trưng.

Có nhiều cách để áp dụng các định nghĩa đó và ý nghĩa của các khái niệm khác nhau tùy thuộc vào việc phân loại là nhị phân hay đa lớp. Trong phân loại nhị phân, một lớp duy nhất được chọn là tích cực và các định nghĩa chỉ được áp dụng cho lớp đó. Do đó, chẳng hạn như thuật ngữ độ chụm đề cập đến độ chụm của lớp tích cực và độ chụm của lớp khác không được tính toán. Trong phân loại đa lớp, các định nghĩa được áp dụng lần lượt cho tất cả các lớp và độ chụm đề cập đến một số tổ hợp độ chụm của từng lớp.

6.5.5.3 Điểm số F1

Điểm số F1 thể hiện hiệu năng của mô hình thông qua sự kết hợp giữa độ thu hồi và độ độ chụm. Điểm F1 được xác định bởi giá trị trung bình hài hòa giữa độ chụm và độ thu hồi. Điểm số F1 đạt giá trị tốt nhất tại 1; nó thể hiện độ chụm và thu hồi hoàn hảo.

6.5.5.4 Độ chính xác

Độ chính xác thể hiện sự phân loại chính xác của một mô hình trong tổng số các phân loại đúng và sai.

Nó chủ yếu có liên quan trong các trường hợp phân loại nhị phân. Trong phân loại đa lớp, nó có thể được hiểu là độ chính xác của mỗi lớp hoặc độ chính xác của mô hình. Độ chính xác của mỗi lớp tương đương với độ thu hồi của lớp đó và khái niệm độ thu hồi được ưu tiên hơn. Độ chính xác của mô hình bỏ qua lớp cụ thể mà mẫu thuộc nó và chỉ xem xét liệu phân loại của nó có đúng hay không bằng cách gom kết quả từ tất cả các mẫu một cách. Tuy nhiên chỉ số này thường ít thông tin hơn so với cặp độ chụm và độ thu hồi hoặc điểm số F1.

Trong phân loại đa nhãn, khái niệm độ chính xác thường đề cập đến độ chính xác của tập con, tức là độ chính xác của việc dự đoán tập nhắn chính xác (xét về tổng thể).

6.5.5.5 Đặc tính hoạt động của máy thu và diện tích dưới đường cong

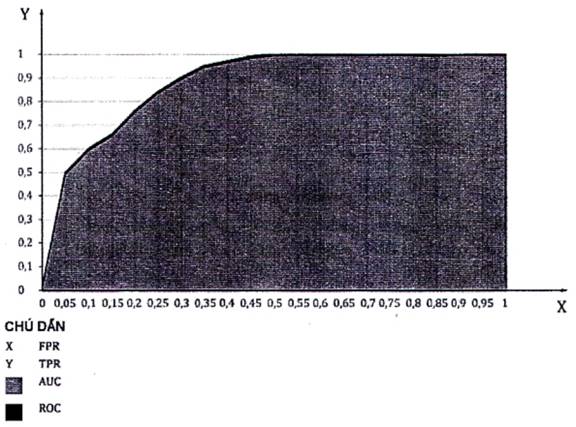

Các đặc tính hoạt động máy thu (ROC) được mô hình hóa dưới dạng một đường cong thể hiện khả năng của một mô hình phân biệt được các lớp. Nó về giá trị TPR theo FPR. Bất kỳ điểm nào trên đường cong đều có thể được chọn làm điểm hoạt động cho mô hình để cung cấp thông tin về TPR và FPR. Như vậy, tùy thuộc vào ứng dụng và tầm quan trọng dành cho TPR và FPR, điểm hoạt động có thể được chọn để tối đa hóa các mục tiêu mong muốn về độ thu hồi và độ chụm. Hình 4 cho thấy một ví dụ về đường cong ROC.

Hình 4 - Đường đặc tính hoạt động của máy thu

Diện tích dưới đường cong ROC (AUC) để đánh giá hiệu năng cho tất cả các ngưỡng phân loại. Giá trị của nó luôn nằm trong phạm vi [0, 1] và có thể được sử dụng để xếp hạng các mô hình. Giá trị AUC cao hơn có giá trị dự đoán tốt hơn. AUC tốt nhất có thể là 1,0 trong khi AUC dự kiến xấu nhất là 0,5 (vì đường chéo tương ứng với các dự đoán ngẫu nhiên). Nếu với bất kỳ giá trị nào nhỏ hơn 0,5 thì có nghĩa là người dùng chỉ cần thực hiện ngược lại chính xác những gì mô hình đề xuất để lấy lại giá trị trên 0,5[9]. Đó sự bất biến về tỷ lệ và ngưỡng phân loại và có thể tốt hoặc xấu tùy thuộc vào ứng dụng. AUC thường được sử dụng khi có sự mất cân bằng lớp trong dữ liệu huấn luyện. Hình 4 cho thấy một ví dụ về AUC là vùng màu xám dưới đường cong ROC.

6.5.5.6 Ma trận nhầm lẫn

Ma trận nhầm lẫn là một bảng cho phép trực quan hóa hiệu năng của mô hình phân loại. Thông thường, các hàng biểu thị số phần tử được dự đoán thuộc một lớp cụ thể trong khi các cột biểu thị số phần tử trong lớp thực tế của chúng. Số lượng tập trung vào đường chéo càng nhiều thì sự nhầm lẫn giữa các lớp càng ít và hiệu năng của mô hình càng tốt. Hình 5 thể hiện trường hợp hai lớp. Trong thiết lập nhị phân cụ thể này, ô trên cùng bên trái là số lượng dương tính thực (TP), ô trên cùng bên phải là số lượng dương tính giả (FP), ô dưới cùng bên trái là số lượng âm tính giả (FN) và ô dưới cùng ô bên phải là số âm tính thật (TN). Ma trận nhầm lẫn cho phép tính toán TPR, FPR, độ chính xác, điểm số F1 và các chỉ số khác.

Hình 5 - Ma trận nhầm lẫn

Ngoài việc phân loại, ma trận nhầm lẫn có thể được vẽ tương tự cho một số tác vụ khác. Nhưng tùy thuộc vào tác vụ, bảng có thể được lấp đầy một phần: ví dụ: trong phát hiện đối tượng, giá trị TN khó xác định.

6.5.5.7 Hệ số Kappa

Hệ số kappa (còn được gọi là Cohen's kappa) đánh giá độ tin cậy giữa những người đánh giá xếp hạng đối với các phần tử phân loại. Trong ML, hệ số kappa đánh giá sự phù hợp giữa phân loại mô hình và nhãn dữ liệu sự thật nền. Nó cũng có thể được sử dụng để kiểm tra mức độ phù hợp của nhiều mô hình và loại bỏ các mô hình có mức độ phù hợp thấp. Hệ số kappa rất hữu ích trong trường hợp bộ dữ liệu không cân bằng vì nó thể hiện hiệu năng của mô hình so với dự đoán ngẫu nhiên bằng sử dụng phân bố mục tiêu của ứng dụng.

Hệ số (K) {0,1} đo lường mức độ đồng thuận giữa những người đánh giá xếp hạng. Phép đánh giá mở rộng mà tại đó những người thu thập dữ liệu (người đánh giá xếp hạng) ấn định cùng một giá trị hoặc điểm số cho cùng một biến hoặc quan sát được gọi là độ tin cậy giữa những người đánh giá xếp hạng. Phép đo này này nắm bắt cơ hội xảy ra mà những người đánh giá xếp hạng dự đoán chủ quan về giá trị của các biến do sự không chắc chắn.

Mặc dù đôi khi được sử dụng làm chỉ số đo hiệu năng của mô hình, nhưng nó không được thiết kế cho các mục đích như vậy và việc sử dụng này không được khuyến nghị trong tài liệu khoa học[10] [11].

6.5.5.8 Hệ số tương quan Matthew

Hệ số tương quan của Matthew (MCC) thể hiện chất lượng hiệu năng phân loại nhị phân. Nó được gọi là hệ số phi (φ) về mặt thống kê và có liên quan đến thống kê chi-bình phương (X2). Nó được tính trực tiếp từ ma trận nhầm lẫn (xem 6.5.5.6):

![]()

7 Phương pháp học máy

7.1 Yêu cầu chung

Các phương pháp ML có thể được phân loại theo ba cách tiếp cận: học máy có giám sát, học máy không giám sát và học máy tăng cường. Học máy bán giám sát, học máy tự giám sát, học chuyển giao và học kết hợp từ nhiều phương pháp ML cùng một lúc.

Cách tiếp cận ML được mô tả trong các điều sau đây có thể sử dụng nhiều phương pháp ML như trong Hình 6. Một số phương pháp đã được mô tả trong Điều 6. Danh sách minh họa trong Hình 6 là ví dụ điển hình và không phải tất cả các phương pháp đều được mô tả trong tiêu chuẩn này. Hình 6 cho thấy một số phương pháp ML được sử dụng bằng nhiều cách tiếp cận ML. Ví dụ, mạng nơ-ron sử dụng trong tất cả các phương pháp tiếp cận ML.

Hình 6 - Các phương pháp ML được phân loại theo học máy có giám sát, học máy không giám sát và học máy tăng cường

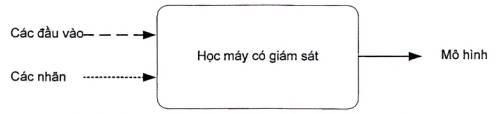

7.2 Học máy có giám sát

Trong học máy có giám sát, các mô hình ML được đào tạo bằng cách sử dụng dữ liệu được gắn nhãn. Dữ liệu được gắn nhãn bao gồm các mẫu có đầu vào được ánh xạ tới đầu ra chính xác hoặc đúng. Do đó, dữ liệu huấn luyện được tổ chức thành các cặp biến đầu vào và đầu ra "đúng". Trong các ngữ cảnh khác nhau, đầu ra đúng còn được gọi là nhãn, biến mục tiêu và sự thật nền. Trong quá trình học có giám sát như minh họa trong Hình 7, thuật toán được khớp đầu vào và đầu ra để tạo ra một mô hình.

Hình 7 - Tạo mô hình ML bằng sử dụng máy học có giám sát

Nhãn có thể là một phần của dữ liệu gốc nhưng thường cần phải tạo nhãn theo cách thủ công hoặc thông qua các quá trình AI khác. Tùy thuộc vào mục tiêu tác vụ ML, nhãn có thể ở nhiều dạng khác nhau:

- Tác vụ phân loại yêu cầu nhãn phân loại (loại mà thực thể dữ liệu thuộc nó, chẳng hạn như một con chó hoặc một tòa nhà);

- Đối với hồi quy thì chúng là giá trị số (các giá trị liên tục như cấp độ, khả năng hoặc xác suất);

- Trong trường hợp dự đoán có cấu trúc, chúng cũng có thể ở dạng đối tượng có cấu trúc (chẳng hạn như chuỗi, hình ảnh, cây hoặc biểu đồ).

Quá trình học máy có giám sát điển hình được minh họa trong Hình 8, cho thấy các quy trình khác nhau trong việc tạo, đánh giá và sử dụng mô hình ML. Giai đoạn "bộ dữ liệu và tạo mô hình" tương ứng với việc chuẩn bị, huấn luyện và lựa chọn mô hình cũng như mọi dữ liệu cần thiết để tạo hoặc đánh giá mô hình. "Đánh giá mô hình" là khi mô hình được kiểm tra bằng sử dụng các chỉ số để đánh giá hiệu năng và sự phù hợp của nó. Trong giai đoạn "sử dụng mô hình", mô hình được áp dụng trên dữ liệu sản xuất để đưa ra dự đoán. Trong khi chiều ngang tương ứng với ba giai đoạn thì chiều dọc cho biết liệu các thành phần và quy trình được mô tả có liên quan đến dữ liệu, mô hình hoặc công cụ hay không.

Hình 8 - Quá trình học máy có giám sát điển hình

Hiệu năng và độ chắc chắn của mô hình được huấn luyện phụ thuộc rất nhiều vào tính đa dạng của dữ liệu huấn luyện (ví dụ: nhiều loại người đi bộ), chất lượng dữ liệu huấn luyện (ví dụ: hiệu ứng ánh sáng hoặc độ phân giải trong ảnh) và độ chính xác của nhãn (ví dụ: gắn nhãn chính xác cho người đi bộ trong lối băng qua đường dành cho người đi bộ). Tất cả các khía cạnh của dữ liệu máy học có giám sát đều dễ bị thiên lệch và cần chú ý đặc biệt trong toàn bộ chu trình từ tạo bộ dữ liệu đến kiểm thử mô hình.

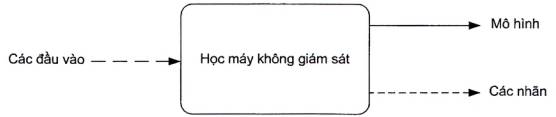

7.3 Học máy không giám sát

Trái ngược với học máy có giám sát, học máy không giám sát ánh xạ trực tiếp đầu vào tới đầu ra mà không được huấn luyện bởi dữ liệu được dán nhãn. Tuy nhiên, quá trình huấn luyện tương tự học máy có giám sát trong Hình 8. Quá trình học không giám sát như minh họa trong Hình 9, thuật toán chỉ được trang bị tại các đầu vào để tạo ra mô hình mà không cần truy cập trước vào các nhãn. Nhãn thường được sản xuất như một sản phẩm đi kèm của quá trình huấn luyện mô hình.

Hình 9 - Tạo mô hình ML sử dụng học máy không giám sát

Ví dụ, trong các tác vụ phân cụm bằng cách sử dụng thuật toán K-trung bình, các mẫu được lặp lại liên tục thông qua thuật toán phân cụm cho đến khi đạt được khoảng cách tối thiểu từ mỗi mẫu đến trọng tâm. Ví dụ: trong các tác vụ giảm chiều, chẳng hạn như sử dụng thuật toán phân tích thành phần chính (PCA), phương sai của từng đặc tính trong dữ liệu đầu vào được tính toán và một số đặc tính được xác định trước với phương sai lớn nhất được trả về. Các mô hình được phát triển theo cách này có thể được sử dụng để xác định tính tương đồng, kiểu cách hoặc điểm bất thường và có thể được sử dụng để giảm kích thước (trong đó các đặc tính liên quan đến thống kê nhất được xác định bất kể nhãn nào). ML không giám sát thường dẫn đến khám phá tri thức.

Các trường hợp sử dụng học máy không giám sát bao gồm:

- khám phá các cụm trong bộ dữ liệu đầu vào;

- phát hiện ra các yếu tố tiềm ẩn. Đối với dữ liệu nhiều chiều, thường mong muốn giảm tính nhiều chiều bằng cách chiếu dữ liệu sang không gian con có chiều ít hơn để nắm bắt "bản chất" của dữ liệu;

- xác định sự tương quan trong tập các phép đo của một vài biến số;

- vẽ lại hình ảnh bị hư hỏng hoặc khiếm khuyết;

- phân tích giỏ hàng để xác định các nhóm hàng hóa thường được mua hoặc bán cùng nhau.

7.4 Học máy bán giám sát

Học máy bán giám sát được định nghĩa là "học máy sử dụng cả dữ liệu được gắn nhãn và không được gắn nhãn trong quá trình huấn luyện". Học máy bán giám sát là sự kết hợp giữa học máy có giám sát và không giám sát.

Một cách tiếp cận để học bán giám sát là tạo và sử dụng nhãn giả để cải thiện hiệu năng tổng thể của mô hình. Trong trường hợp này, đầu tiên mô hình được huấn luyện bằng cách sử dụng dữ liệu được gắn nhãn. Tiếp theo là sử dụng mô hình đã được huấn luyện để dự đoán nhãn giả cho các mẫu dữ liệu chưa được gắn nhãn. Cuối cùng, một bộ dữ liệu huấn luyện được tạo bằng việc sử dụng cả mẫu đã được gắn nhãn và gắn nhãn giả để tái huấn luyện mô hình. Cách tiếp cận này được gọi là tự huấn luyện.

Học bán giám sát rất hữu ích trong trường hợp việc ghi nhãn tất cả các mẫu trong bộ dữ liệu huấn luyện lớn bị hạn chế xét về thời gian hoặc chi phí.

7.5 Học máy tự giám sát

Học máy tự giám sát là một cách tiếp cận để huấn luyện bởi dữ liệu chưa được gắn nhãn bằng các thuật toán thường sử dụng trong học máy có giám sát. Điều này đạt được bằng cách sử dụng các nhãn ẩn, chẳng hạn như là chính đầu vào của nó (ví dụ: hình ảnh để tái tạo lại giống nhau), một phần của đầu vào (ví dụ: một từ trong câu ở đầu vào) hoặc bất kỳ nhãn nào khác có thể dễ dàng tạo ra từ dữ liệu thô (ví dụ: phiên bản chưa xáo trộn của một chuỗi đã được xáo trộn một cách giả tạo). Nó thường được áp dụng đối với lượng lớn dữ liệu.

Học máy tự giám sát thường được sử dụng để học các biểu diễn: đầu ra cuối cùng của mô hình bị loại bỏ và đầu ra trung gian có thể được sử dụng lại làm đầu vào cho một mô hình ML khác. Điều này đặc biệt hữu ích để xử lý dữ liệu phi cấu trúc, đồng thời làm giảm việc thực thi kỹ thuật trích chọn đặc tính dữ liệu.

Lưu ý rằng học máy tự giám sát không liên quan đến tự huấn luyện, đây là một phương pháp cụ thể cho học máy bán giám sát.

7.6 Học máy tăng cường

Học tăng cường khác với các phương pháp khác, vì nguyên tắc của nó là mô hình được khởi tạo ở một trạng thái, một hành động được thực hiện, phần thưởng cho hành động được xác định và mô hình được chuyển sang trạng thái mới nhằm cố gắng tối đa hóa phần thưởng. Huấn luyện có thể được sử dụng để khởi tạo mô hình hoặc xác định các chính sách mà mô hình sử dụng để thực hiện các hành động.

Học máy tăng cường là quá trình huấn luyện một hoặc nhiều tác nhân tương tác với môi trường của chúng để đạt được mục tiêu xác định trước. Trong học máy tăng cường, các tác nhân ML học thông qua một quá trình thử và sai lặp đi lặp lại. Mục tiêu của tác nhân là tìm ra chiến lược (tức là xây dựng một mô hình) để nhận được phần thưởng tốt nhất từ môi trường. Đối với mỗi thử nghiệm (thành công hoặc không thành công), môi trường sẽ cung cấp phản hồi gián tiếp. Sau đó, tác nhân điều chỉnh hành vi của nó (tức là mô hình của nó) dựa trên phản hồi này. Quá trình này được minh họa trong Hình 10. Tác nhân xác định những tương tác nào luôn mang lại phần thưởng tối đa cho các hành động của tác nhân để thỏa mãn được mục tiêu.

Hành động và tương tác của tác nhân với môi trường thường được mô hình hóa dưới dạng quá trình ra quyết định Markov (MDP). Hình 10 là một đại diện điển hình của MDP. Các thuật toán học máy tăng cường không nhất thiết phải nhận biết theo mô hình toán học chính xác của MDP (nhưng một số kỹ thuật khác cố gắng xấp xỉ nó). Các thuật toán học máy tăng cường thường hướng tới mục tiêu là các MDP lớn, nơi các phương pháp chính xác trở nên không khả thi. Không giáng như học máy có giám sát, các cặp đầu vào được ánh xạ tới đầu ra đúng, được gắn nhãn là không bắt buộc. Thay vào đó, mục tiêu là sử dụng phép thử và sai, hội tụ các kết quả về một mục tiêu cụ thể thông qua cơ chế nhận phần thưởng trì hoãn. Mỗi khi mô hình đưa ra dự đoán, phần thưởng sẽ được tính toán và các phép thử tiếp theo sẽ được chạy để tối ưu hóa phần thưởng. Phần thưởng nói chung là một con số được tính toán thể hiện mức độ gần đạt được mục tiêu của hệ thống đối với một phép thử nhất định. Trong một số trường hợp, thông tin bổ sung về môi trường được mô hình hóa hoặc thông tin bổ sung được cung cấp cho thực thể để cải thiện hiệu năng huấn luyện. Mục tiêu hoặc định nghĩa về sự thành công thường được xác định bởi nhà thiết kế hệ thống.

Học máy tăng cường cũng có thể kết hợp với học máy có giám sát: huấn luyện với dữ liệu được gắn nhãn sử dụng để khởi tạo mô hình và học tăng cường được sử dụng để xác định các chính sách tiếp theo mà tác nhân sử dụng để thực hiện các hành động.

Trong một số trường hợp (ví dụ: dự đoán có cấu trúc), bản thân ứng dụng học máy tăng cường có thể phụ thuộc vào sự tồn tại trước đó của bộ dữ liệu (được gắn nhãn) do cần phải tạo môi trường: trong những trường hợp như vậy, môi trường hoạt động đại diện cho thông tin có trong bộ dữ liệu.

Học máy tăng cường tạo điều kiện thuận lợi cho việc áp dụng học liên tục, vì môi trường huấn luyện có thể là môi trường mô phỏng hoặc môi trường thực tế trong giai đoạn vận hành, miễn là có đủ thông tin để tính toán phần thưởng trong các giai đoạn đó.

Học máy tăng cường thường được sử dụng cho mục đích điều khiển. Điều khiển là ứng dụng của học máy tăng cường để tương tác với một môi trường. Tìm một chính sách tối đa hóa phần thường khi các hành động tuân theo chính sách này được thực hiện cho phép lập kế hoạch hoạt động và điều khiển tối ưu.

Các trường hợp sử dụng máy học củng cố bao gồm chơi trò chơi điện tử video tương tác hoặc cờ bàn, trong đó mục tiêu là tối đa hóa các nước đi trong trò chơi và do đó giành quyền kiểm soát kết quả của trò chơi.

Hình 10 - Quá trình học máy tăng cường điển hình

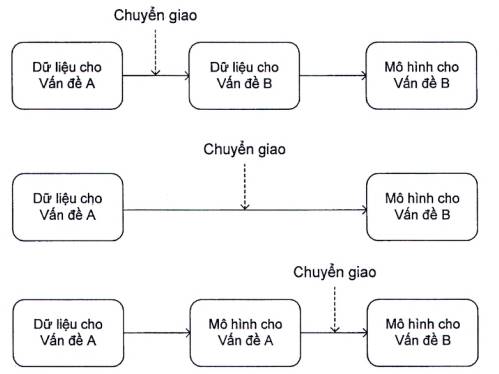

7.7 Học chuyển giao

Học chuyển giao đề cập đến một loạt các phương pháp tập trung vào lưu trữ và trừu tượng hóa tri thức thu được từ dữ liệu nhằm giải quyết một vấn đề để áp dụng nó cho một vấn đề khác có thể có mối liên hệ lỏng (ví dụ: giải quyết cùng một tác vụ trong lĩnh vực khác biệt nhau đáng kể). Ví dụ: kiến thức thu được từ việc nhận dạng số nhà trong chế độ xem phố có thể được sử dụng để nhận dạng các số viết tay.

Một ví dụ nổi tiếng về mô hình học máy này là kỹ thuật tinh chỉnh, trong đó một mô hình đã được đào tạo để giải quyết vấn đề đầu tiên được sử dụng lại và huấn luyện thêm để giải quyết vấn đề mới. Ví dụ: một mô hình đã học cách nhận dạng đồ nội thất và đồ vật có thể được tinh chỉnh để xác định khung cảnh (ví dụ: phòng khách, bãi biển, nhà bếp, v.v.) bằng cách huấn luyện mô hình đó trên các bức ảnh của bối cảnh mới.

Nhiều phương pháp khác đã được thiết kế để đạt được chuyển giao, bao gồm tổng nhận dạng thực thể, thuật toán dựa trên đặc tính hoặc kỹ thuật quy tắc hóa [13].

Trong thực tế, học chuyển giao dựa trên các phương pháp học khác được bổ sung các bước lưu trữ và trừu tượng hóa tri thức để sử dụng lại sau này. Như minh họa trong Hình 11, các phương pháp chuyển giao có thể được áp dụng trước, trong hoặc sau khi quá trình học xảy ra.

Hình 11 - Quá trình học chuyển giao điển hình

8 Quy trình học máy

8.1 Yêu cầu chung

Để đạt được mục tiêu ứng dụng cụ thể sử dụng ML, mô hình ML được tạo ra, đánh giá và đưa vào sử dụng. Quá trình này thường liên quan đến dữ liệu, thuật toán và tài nguyên tính toán. Điều khoản này mô tả quy trình ML điển hình, bao gồm các quá trình áp dụng ở mỗi bước. Trước khi vào quy trình này cần xác định tác vụ hoặc vấn đề cần giải quyết. Điều này có nghĩa là thiết lập các mục tiêu và yêu cầu của giải pháp. Định nghĩa chính xác và chi tiết vấn đề cần giải quyết (bao gồm, ví dụ: định nghĩa chính xác về định dạng đầu vào và đầu ra) để hỗ trợ việc chọn thuật toán ML phù hợp và để có được các bộ dữ liệu liên quan cần thiết cho huấn luyện mô hình ML.

Hình 12 minh họa các quy trình ML cụ thể liên quan đến việc phát triển, xác minh, triển khai và vận hành một mô hình ML cũng như cách chúng liên quan đến các giai đoạn vòng đời của hệ thống AI. Các khía cạnh sau áp dụng trên toàn bộ quy trình ML:

- quản lý rủi ro và quản trị;

- an ninh và sự riêng tư;

- trách nhiệm giải trình, tính minh bạch và khả năng giải thích;

- an toàn, khả năng phục hồi, tính mạnh mẽ và công bằng.

Hình 12 - Quy trình học máy và ánh xạ đến vòng đời hệ thống AI

Các điều khoản con sau đây mô tả các giai đoạn của quy trình thể hiện trong Hình 12 và các quá trình có khả năng xảy ra như một phần của mỗi giai đoạn. Việc thiết kế và phát triển một mô hình ML gồm một số bước tuần tự và không tuần tự. Nó bắt đầu với các công việc chuẩn bị, bao gồm ba bước là thu thập và chuẩn bị bộ dữ liệu, thực hiện kỹ thuật trích chọn đặc tính và chọn một thuật toán đã cho. Không có sự phụ thuộc chung giữa các quá trình đó và về nguyên tắc chúng có thể được tiến hành theo bất kỳ trình tự nào hoặc đồng thời. Tuy nhiên, tùy thuộc vào trường hợp sử dụng cụ thể, về nguyên tắc có thể có các ràng buộc kỹ thuật bổ sung để thực thi bất kỳ yêu cầu cụ thể nào hoặc yêu cầu lặp lại giữa các quá trình đó. Chẳng hạn, việc phân tích bộ dữ liệu có thể giúp thiết kế các đặc tính tốt hơn; và mức độ chi tiết của các đặc tính được thiết kế có thể dẫn đến việc lựa chọn thuật toán phụ thuộc ít hay nhiều vào các đặc tính đó; nhưng việc lựa chọn thuật toán cũng có thể hạn chế loại hoặc mức độ chi tiết của nhãn để chú giải trên dữ liệu thu thập, trong trường hợp đó cần phải chọn thuật toán trước.

Việc tạo mô hình thực tế xảy ra sau khi tất cả các bước chuẩn bị đã được thực hiện. Điều này bao gồm huấn luyện một hoặc nhiều mô hình ứng viên, sau đó chọn mô hình ứng viên tốt nhất trong số đó.

8.2 Thu thập dữ liệu

Giai đoạn ban đầu để phát triển, triển khai và vận hành mô hình ML là thu thập dữ liệu. Dữ liệu là một thành phần quan trọng trong vòng đời của mô hình ML, vì cả quá trình huấn luyện và đánh giá đều dựa vào dữ liệu đó. Việc thu thập và chuẩn bị dữ liệu cần được xem xét cẩn thận để dữ liệu thu được phù hợp với mục đích làm việc của mô hình. Dữ liệu huấn luyện thường là một tập con của một quần thể dữ liệu lớn hơn, đại diện lý tưởng cho quần thể dữ liệu đó. Dữ liệu sử dụng đề huấn luyện các mô hình học máy có giám sát sẽ bao gồm một hoặc nhiều nhãn hoặc biến mục tiêu, thể hiện sự thật về mẫu hoặc bản ghi dữ liệu. Ví dụ: mỗi email trong tập các email huấn luyện có thể được gắn nhãn là "thư rác" hoặc "không phải thư rác".

Các mô hình ML sẽ cần dữ liệu kiểm tra và thẩm định để xác định độ chính xác và các chỉ số hiệu năng khác của chúng. Dữ liệu kiểm tra và thẩm định có thể được thu thập cùng với dữ liệu huấn luyện hoặc chúng có thể là các bộ dữ liệu tương tự được thu thập bằng các cách thức khác nhau.

Loại dữ liệu cần thiết phụ thuộc vào vấn đề cần được giải quyết. Ví dụ: dự báo doanh số bán hàng có thể yêu cầu quyền truy cập vào dữ liệu giao dịch. Phân loại hình ảnh có thể yêu cầu quyền truy cập vào tệp hình ảnh. Tương tự như vậy, vấn đề cần giải quyết nêu rõ thông tin nào (tức là đặc tính nào) cần thiết trong bộ dữ liệu. Các nguồn dữ liệu được nhận biết và dữ liệu cần thiết được thu thập (ví dụ: được mua hoặc thông qua hoạt động thu thập). Dữ liệu có thể đến từ nhiều nguồn, có thể từ kho lưu trữ dữ liệu cố định hoặc từ các luồng dữ liệu. Các nguồn dữ liệu huấn luyện phổ biến bao gồm giao dịch, cảm biến, truy vấn, hình ảnh, tài liệu, âm thanh và phương tiện truyền thông mạng xã hội.

8.3 Chuẩn bị dữ liệu

Dữ liệu hiếm khi sẵn sàng để sử dụng ngay cho huấn luyện các mô hình ML. Các mô hình ML thường có các yêu cầu về dữ liệu sử dụng để huấn luyện nó. Việc chuẩn bị dữ liệu thường tiêu tốn một lượng thời gian và công sức đáng kể để phát triển một mô hình ML. Chuẩn bị dữ liệu có thể liên quan đến việc sử dụng một số công cụ tự động để định dạng và làm sạch các bộ dữ liệu khác nhau. Chuẩn bị dữ liệu bao gồm định dạng dữ liệu thành dạng mà hệ thống cụ thể có thể sử dụng và cho hoạt động làm sạch dữ liệu. Làm sạch dữ liệu có thể bao gồm quá trình loại bỏ dữ liệu trùng lặp và dữ liệu giả (dữ liệu không hữu ích để giải quyết vấn đề) và sửa dữ liệu bị thiếu. Dữ liệu nhiễu có thể chứa các bản ghi sai hoặc ngoại lệ có thể được xử lý ở giai đoạn này. Điều này cũng bao gồm việc hủy nhận dạng: mặc dù dữ liệu thu được có thể đã được hủy nhận dạng trước đó, nhưng vẫn có thể cần phải hủy nhận dạng bổ sung cho quá trình xử lý dữ liệu (ví dụ: ghép các bộ dữ liệu) trong giai đoạn này. Ví dụ về các quá trình này được thảo luận dưới đây đề cập đến khám phá, sắp xếp lại, làm sạch, quy nạp, chuẩn hóa và chia tỷ lệ, thành phần bộ dữ liệu, tách dữ liệu và ghi nhãn. Chúng cũng có thể được áp dụng theo một trình tự khác.

Khám phá: Khám phá liên quan đến việc kiểm tra dữ liệu thô. Mục đích là để có được những hiểu biết sâu sắc giúp xác định quá trình nào là cần thiết để chuẩn bị dữ liệu cho huấn luyện mô hình. Ví dụ: thông tin chi tiết bao gồm hình dạng của bộ dữ liệu, loại dữ liệu, giá trị trung bình, phương sai và phạm vi của dữ liệu số, sự tồn tại của chỉ mục, đặc tính và nhãn.